Introduction

2017년 농림어업조사 결과에 따르면 2013년 농가 인구는 284만 7,435명, 농가 수는 114만 2,029가구에서, 2017년 농가 인구는 242만 2,256명, 농가 수는 104만 2,017가구로 감소세가 지속되고 있으며, 고령화율(65세 이상 인구 비율)은 2013년 37.3%에서 2017년 42.5%로 증가하였다(KOSIS, 2018). 국내 농경지 면적의 경우 전체면적 대비 2000년 19.0%에서 2017년 16.2%로 하락 추세에 있으며, 국내 총생산 중 농림어업의 비중은 2000년 4.4%에서 2017년 2.2%로 감소하였다(MAFRA, 2018). 또한 국제연합식량농업기구(Food and Agriculture Organization, FAO) 자료에 의하면, 2013 - 2015년 우리나라 곡물자급률은 23.8%를 기록했으며, 이는 국내에서 소비되는 곡물류의 약 80%가 수입품을 의미한다. 전 세계 평균 곡물 자급률 102.5%인 것을 감안하면 국내 곡물자급률은 낮은 수준이다(KREI, 2018). 이처럼 우리나라 농업에 직면한 작물 생산성 저하와 기후변화 대응 능력의 부재, 농가 인구 감소 및 고령화를 해결하기 위한 방안으로 정보통신기술(information and communications technologies, ICT), 사물인터넷(internet of things, IoT), 빅데이터(big data) 등을 접목한 스마트 농업 기술 개발이 대두되었다(Lee et al., 2014; Hong et al., 2016; Jayaraman et al., 2016; Lokers et al., 2016; Nam et al., 2017; Ray, 2017; Balducci et al., 2018).

스마트 농업 기술 중 하나인 스마트 팜(smart farm or smart farming)은 원격으로 현장을 제어할 수 있기 때문에 최소 노동력으로 농장 운영이 가능하며, 자동 환경 제어를 통하여 균일하고 품질 좋은 작물의 생산이 가능하다(Walter et al., 2017). 국내의 경우 한국형 스마트 팜 모델 개발을 위한 연구가 수행되었으며, 이상기후로 인한 병해충, 질병 등의 피해 예방 및 최소화를 위하여 스마트 팜을 이용한 데이터를 기반으로 생육 관리 전략을 구축하고 있다(Kim, 2017). 또한 농촌진흥청(Rural Development Administration, RDA)에서는 지능형 정밀 생육 관리를 위한 스마트 팜 기술을 토마토 대상으로 검증 중이며, 농산업 부문 혁신 성장을 위해 스마트 팜 확산의 일환으로 스마트 팜 혁신 밸리 조성을 추진 중에 있다(KREI, 2019). 따라서, 스마트 팜 기술의 도입에 따라 온실 내 설치된 다양한 센서를 통해 빅데이터를 구축하고, 기계학습(machine learning), 딥러닝(deep learning)을 통해 작물의 생육 상태를 파악하고 농장 내 활동을 자동화 및 체계화하는 연구가 필요하다(Lanfley, 1995; McQueen et al., 1995; Wolfert et al., 2017; Kamilaris and Prenafeta-Boldu, 2018; Liakos et al., 2018; Kamienski et al., 2019).

본 연구에서는 딥러닝 기술을 이용하여 대상 작물인 딸기의 생육시기별 이미지로부터 생육 시기 및 최적의 수확 시기를 판별하고자 한다. 구글(Google)에서 제공하는 오픈소스(open source) 라이브러리인 텐서플로우(TensorFlow, )를 활용하였으며, 딸기의 생육 시기 분류를 이미지 내 객체 추론(object inception)과 객체 검출(object detection)의 두 가지 방법을 적용하였다. 객체 추론을 위해 학습 데이터량 및 학습 횟수에 따른 분류 정확도를 비교하였고, 객체 검출을 위해 학습 횟수에 따른 검출 정확도를 비교하여 최적의 학습 횟수를 도출하고자 하였으며, 최적의 학습 횟수를 적용하여 각 생육 시기별 딸기의 검출 및 생육 시기 분류를 수행하고자 한다.

Materials and Methods

대상 작물 및 이미지 데이터 구축

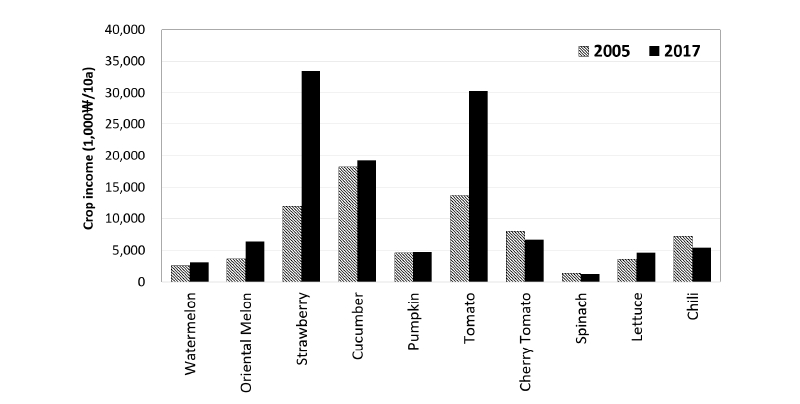

본 연구에서는 대상 작물을 선정하기 위하여, 작물 이미지 취득 용이성 파악을 위해 국내 주요 시설 재배 작물의 현황을 살펴보았으며, 작물 이미지 구축 및 적용성을 확인하기 위해 재배방법을 조사하였다. 농촌진흥청의 농축산물 소득 자료집(RDA, 2018)에 따르면 Fig. 1과 같이 2005년 대비 2017년 딸기 소득이 성장세를 나타냈으며, 품종개량, 재배 기술 개선 등으로 품질이 향상되고 소비가 확대되어 생산액이 증가될 것으로 예상된다(Kim et al., 2017). 경상북도 농업기술원에 따르면 딸기 재배 하우스에 스마트 팜을 도입하면 소득이 평균 21.5% 상승하는 것으로 나타나 추후 스마트 팜 시범 적용에 용이할 것으로 판단된다(Yu, 2016). 시설 재배 작물 이미지 취득의 용이성, 스마트 팜 적용 가능 여부 등을 판단하여 시설 재배 작물인 딸기를 대상 작물로 선정하였다. 딸기는 다른 과실에 비해 전반적으로 육질이 약하여 수확 시기가 늦어질 경우 상품성이 떨어지기 쉽고(Bae et al., 2016), 수송 적응성에 따라 유통경로가 달라진다. 수확 시기는 과실의 착색 정도에 따라 결정되며, 착색이 진행됨에 따라 경도와 산 함량은 감소하고 당이 증가하여 식미 품질이 높아진다. 특히 딸기는 모종을 다 키운 후 2 - 3개월 동안 수확하게 되는데 성숙기(수확기)에 수확하는 것이 중요하다.

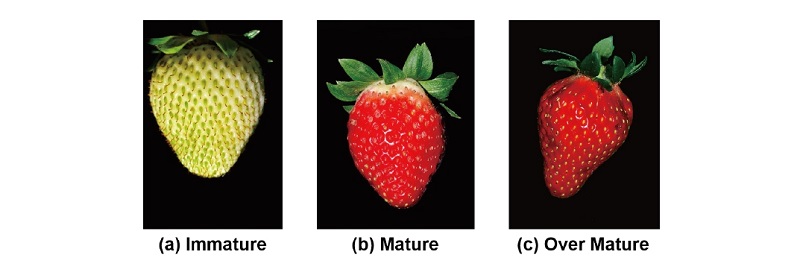

본 연구에서는 농촌진흥청에서 제공하는 딸기 적정 수확기를 고려하여 생육 시기를 미성숙기(immature), 성숙기(mature), 과성숙기(over mature)의 3단계로 구분하였다. 미성숙기는 과실의 착색도가 70% 이하인 경우로 이 상태의 과실은 착색되지 않은 부분이 다소 짙거나 옅은 녹색을 지닌 상태다. 성숙기는 착색도가 80 - 90%인 경우로 꽃받기 부근 착색되지 않은 부위가 엽록소가 모두 분해되지 않고 남아있어 약간 짙은 녹색을 띠는 경우가 많다. 과성숙기는 100% 착색된 상태로 꽃받침 조각에 가려진 부위까지 착색이 진행된 것이다. 이미지 학습을 통해 학습 데이터량과 학습 횟수를 다르게 적용하여 생육 시기 분류 정확성을 확인하고자 생육 시기별 학습 데이터 100, 150, 200개, 검증 데이터는 20개의 이미지로 구축하였다. 학습 데이터와 검증 데이터는 온실 내의 이미지로 구성하였다.

전이학습(Transfer Learning)을 통한 생육 시기 추론

딥러닝 기법의 하나인 CNN (convolutional neural network)은 생물의 시신경이 동작하는 원리를 바탕으로 이미지 데이터 처리에 적합한 구조로 만들어진 신경망이다(Oquab et al., 2014; Espejo-Garcia et al., 2018; Shine et al., 2018). 이미지를 분류하기 위해서는 가중치 학습이 필요하며, CNN 학습에는 각 객체마다 최소 1,000개 이상의 데이터가 필요하다(Mohanty et al., 2016). 본 연구의 분류 대상인 딸기의 생육 시기별 데이터 취득에는 한계가 존재하여 전이학습(transfer learning)을 통해 기존 네트워크를 바탕으로 새로운 인식 작업을 위해 재학습(retraining)을 수행하였다. 전이학습의 경우 최소 100개에서 1000개의 이미지로 학습이 가능하며, 성능과 학습 시간적인 면에서도 좋은 결과를 보인다.

이미지 분류 및 인식 분야는 컴퓨터 비전 프로젝트인 ILSVRC (ImageNet Large Scale Visual Recognition Competition)에서 CNN을 기반으로 연구가 수행되었다. Inception 모델은 2014년 ILSVRC에서 발표한 모델로서, Inception V3는 이전 Inception V1, Inception V2에서 사용하지 않았던 batch normalization, 필터 사이즈의 감소(7 × 7에서 3 × 3) 등 변환을 적용하여 만들어진 모델이다(Szegedy et al., 2016). 이를 이용한 이미지 인식 코드는 구글에서 공개하여 다른 모든 영역에서 사용자가 스스로 훈련 시킨 모델을 사용하는 등 코드 활용이 가능하다.

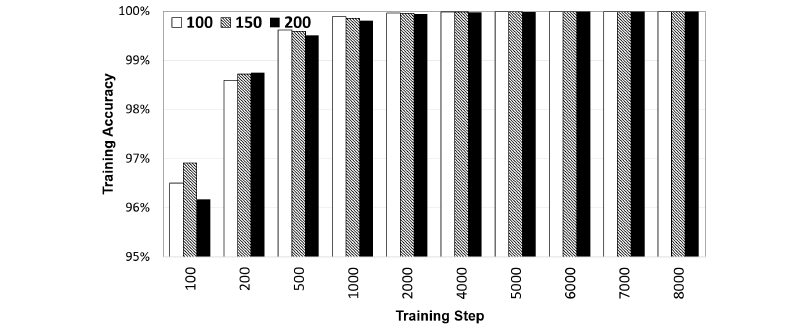

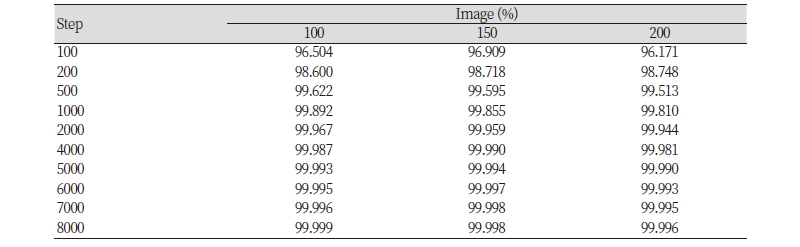

본 연구에서는 Inception V3을 이용하여 전이 학습을 통해 딸기 생육 시기를 분류하여 추론하고자 하였다. 학습 데이터는 생육 시기별 100, 150, 200개의 데이터셋으로 구성하였고, 동일한 학습 데이터를 이용하여 학습 횟수를 100, 200, 500, 1000, 2000, 4000, 5000, 6000, 7000, 8000회로 변화를 주어 정확도를 산정하였다.

텐서플로우(TensorFlow)를 활용한 객체 검출

본 연구에서는 대상 작물인 딸기의 생육 시기를 구분하고 기계학습 활용하여 이미지 학습을 통해 생육 시기의 분석을 실시하였다. 이미지 학습에는 구글의 기계학습 프레임워크인 TensorFlow를 활용하였다. 텐서플로우는 기계학습과 딥 뉴럴 네트워크(deep neural network) 연구를 목적으로 개발된 시스템으로 다양한 하드웨어 환경에서 인공 신경망 모델을 쉽게 생성하고 학습할 수 있는 인터페이스를 제공하며, 연구자가 인공 신경망(artificial neural network) 모델 학습에 필요한 하드웨어 조작 없이 인공 신경망 모델 구조에 집중할 수 있는 환경을 제공한다(Miao et al., 2006; Kamilaris et al., 2017; Zaborowicz et al., 2017; Lim et al., 2018). 객체 검출 라이브러리는 TensorFlow에 구축된 오픈 소스 프레임워크로, 객체 탐지 모델을 구성하여 단일 이미지 내 객체의 지역화(localizing) 및 식별을 위해 사용되고 있다.

Results and Discussion

이미지 학습에 따른 작물의 생육 시기별 분류

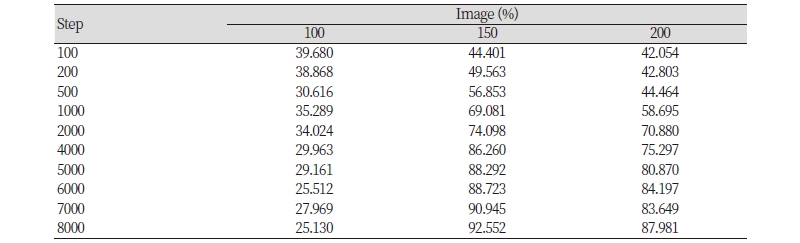

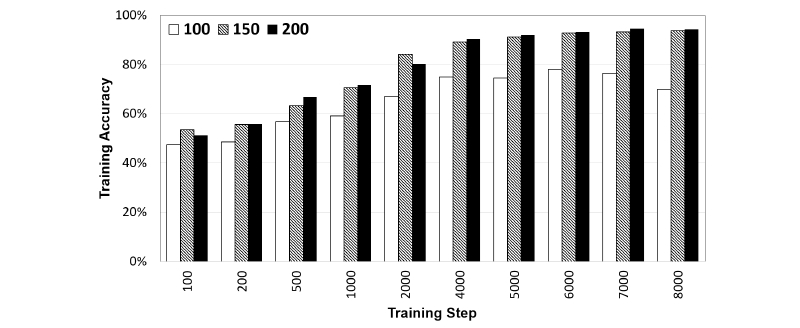

딸기의 생육 시기를 3단계로 구분하여 학습하기 위하여, 시험 데이터는 Fig. 2와 같이 구성하였으며, (a)미성숙기, (b)성숙기, (c)과성숙기 각 생육 시기별 결과를 도출하였다. Table 1과 Fig. 3은 (a)미성숙기에 대한 결과로 이미지 개수 100개, 학습 횟수 100회일 때 96.504%의 정확도로 분류하였고, 학습 횟수 8000회일 때는 99.999%를 나타내었으며, 학습 이미지 100, 150, 200개 모든 경우의 정확도가 100%에 가깝게 수렴하였다. 이는 테스트 이미지가 착색이 전혀 이루어지지 않은 녹색으로 이루어져 있어 높은 정확도로 분류가 가능했던 것으로 판단된다. Fig. 4와 Table 2는 (b)성숙기에 대한 결과로 학습 데이터가 100개일 때 그 정확도가 학습 횟수를 거듭할수록 정확도가 떨어졌다. 학습 데이터 100개, 학습 횟수 100회일 때 40%대의 정확도를 보였으며, 학습 횟수가 8,000회일 때는 20%대로 정확도가 약 두 배 떨어졌다. 이는 CNN과 같은 인공 신경망 모델에서 생성된 모델이 학습 데이터에 지나치게 유사하여 발생하는 문제인 오버 피팅(overfitting)에 의한 것으로 판단된다. 이는 모델 학습 과정에서 부족한 학습 데이터로 야기되는 문제이며, 학습 데이터양을 늘려 다양한 경우의 수를 생성하여 해결해야 한다.

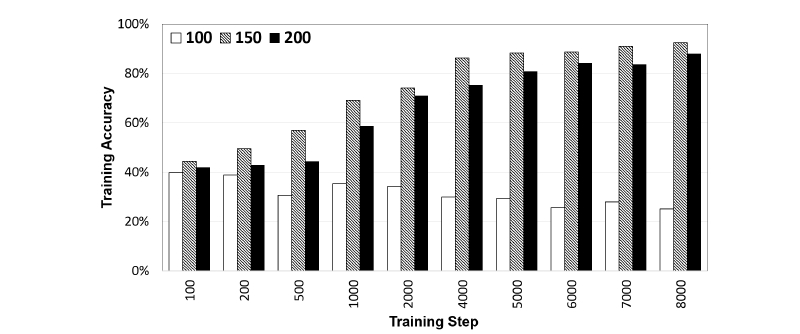

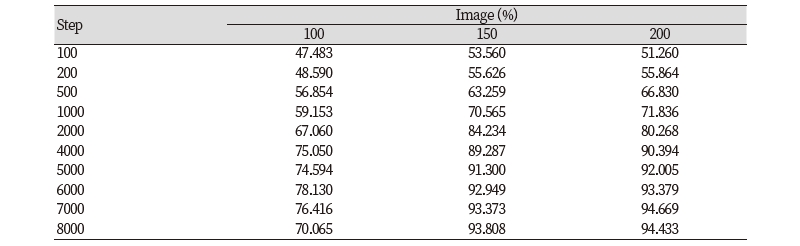

생성된 모델이 학습 데이터가 150개인 경우에는 학습 횟수 7,000회부터 90% 이상의 정확도를 보여 분류가 가능하였다(Fig. 4). 학습 데이터가 200개인 경우에는 8,000회의 학습 횟수에도 87.981%의 정확도를 보이며, 비교 대상인 미성숙기와 과성숙기로 인식되는 정확도에 비해 높은 정확도를 나타냈다. 이는 학습 데이터에 과실의 꽃받기가 가려져 있는 딸기 이미지와 가려져 있지 않은 이미지를 포함하였으나 꽃받기가 가려져 있는 부분의 이미지 학습이 정확히 이루어지지 않아 과성숙기로 인식된 것으로 판단된다. Fig. 5, Table 3는 (c)과성숙기에 대한 결과로 학습 데이터가 100개인 경우 최대 70%의 정확도를 보였다. 학습 데이터가 150개인 경우는 학습 횟수 5,000회부터, 200개인 경우는 학습 횟수 4,000회부터 90% 이상의 정확도를 보이며 성숙기의 경우에 비해 안정적인 결과를 보였다.

학습 횟수별 딸기의 성숙 단계 분류 정확도 비교

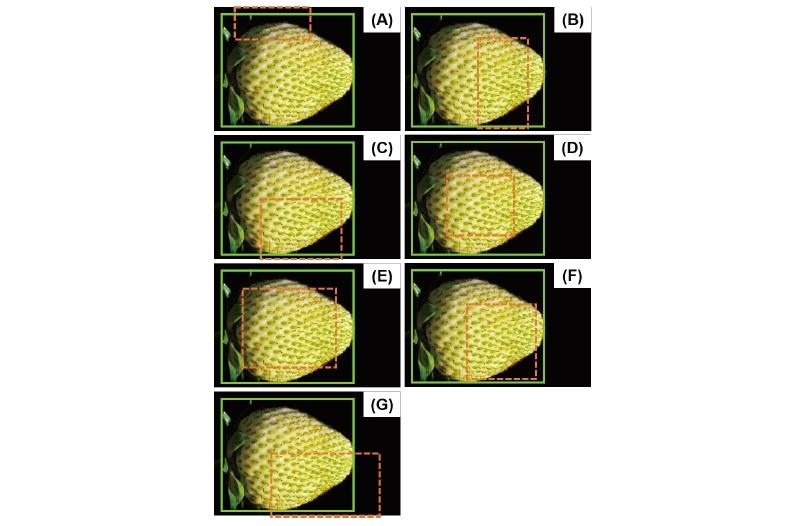

온실 내 작물 이미지 취득 시 여러 개의 작물에 대한 각각의 성숙 시기를 파악하기 위해 객체 검출이 필요하다. 딸기의 생육 시기를 분류하기 위한 최적의 학습 횟수를 도출하기 위해 동일한 학습 데이터와 테스트 이미지를 사용하고 학습 횟수를 (A)100, (B)2,000, (C)20,000, (D)50,000, (E)100,000, (F)150,000, (G)200,000회를 적용하였다. 학습 데이터는 미성숙기 200장, 검증 데이터는 20장을 구축하였으며, 결과는 Fig. 6과 같다. (A)100, (B)2,000, (C)20,000회의 경우 딸기를 벗어나 제대로 식별되지 않음을 확인하였다. (D)50,000, (E)100,000회의 경우 딸기의 중앙 부분에 위치되었으나 50,000회의 결과는 실제 객체보다 매우 작게 식별되어 식별이 제대로 이루어졌다고 볼 수 없다. 100,000회 이상 학습하였을 경우, 20,000회 학습하였을 때와 비슷한 결과가 나타났으며, 딸기의 식별 및 생육 시기 분류에 있어 학습 횟수는 100,000회가 적합한 것으로 판단된다.

객체 라이브러리를 이용한 생육 시기별 다중 객체 검출

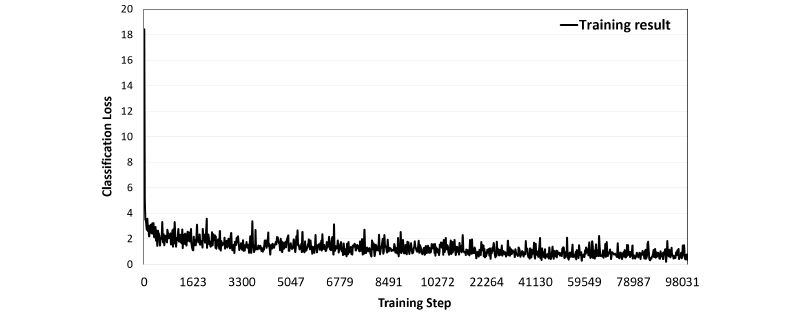

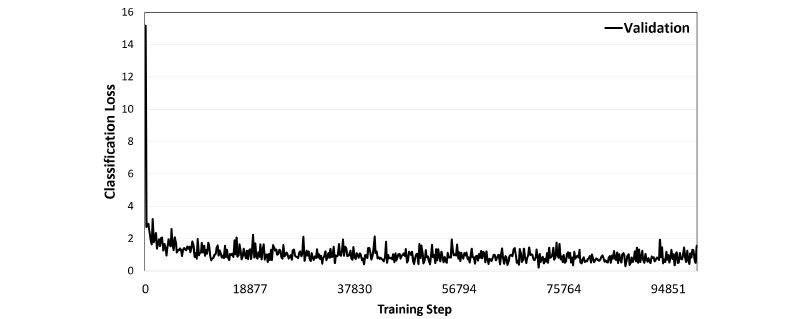

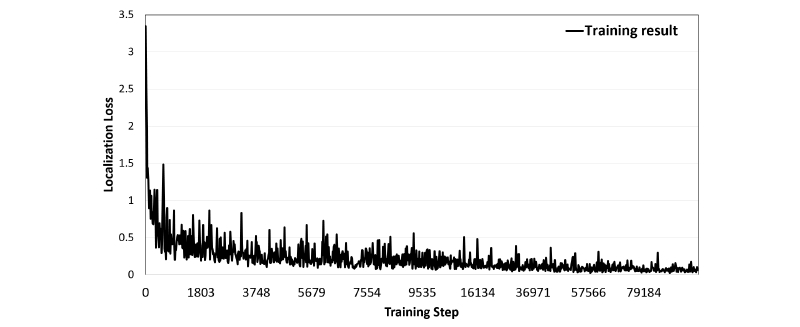

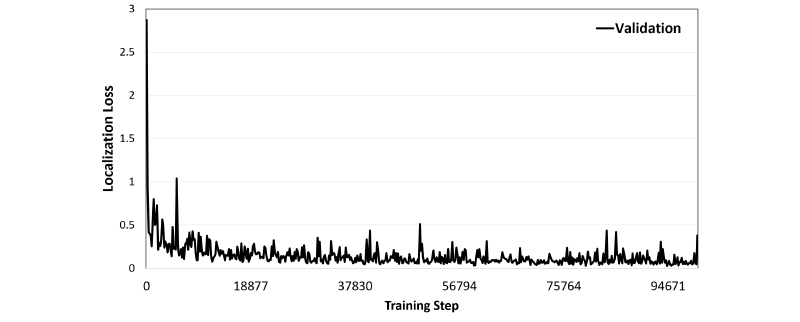

단일 이미지 내 3단계 성숙도의 딸기를 식별하기 위하여 객체 검출 라이브러리를 사용하였다. 미성숙기, 성숙기, 과성숙기의 이미지를 각각 200장씩 총 600장의 학습 데이터를 구축하였고, 검증 데이터는 20개로 총 60개로 구축하였다. 학습 횟수는 앞서 학습 횟수별 딸기 검출에서 가장 적합했던 100,000회로 진행하였다. Fig. 7은 학습 횟수에 따른 학습 데이터에 대한 classification loss를 나타낸 그래프이며, classification loss는 식별된 객체의 클래스 분류에 대한 손실을 의미한다. step 0의 손실 값 18.427에서 최종 손실 값 0.370으로 학습되었고, 약 540회의 학습이 진행된 이후 손실 값이 1로 줄어드는 결과를 보였다. Fig. 8은 학습 횟수에 따른 검증 데이터의 classification loss를 나타낸 그래프이며, Step 0의 손실 값 15.168에서 최종 손실 값 1.564를 나타내었다. Fig. 9는 학습 모델의 학습 횟수에 따른 학습 데이터에 대한 localization loss를 나타낸 그래프로, 경계 박스 변수의 손실과 위치 정보의 손실을 의미한다. step 0의 손실 값 3.347에서 0.061으로 감소하였다. Fig. 10은 학습 모델의 학습 횟수에 따른 검증 데이터의 localization loss를 나타낸 그래프이며, step 0의 2.871에서 0.380으로 감소하는 경향을 보였다.

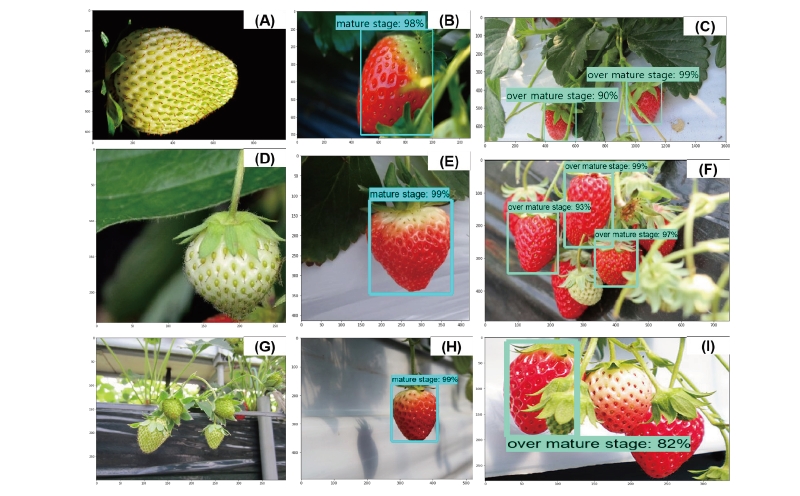

각 생육 시기별로 3개의 이미지를 이용하여 테스트한 결과는 Fig. 11과 같다. 미성숙기의 테스트 이미지(A, D, G)가 모두 착색도 0%를 보이고 있음에도 전혀 식별이 이루어지지 않았다. 앞서 학습 횟수별 딸기 검출과 같은 이미지로 테스트하였으나 전혀 식별되지 않은 것은 미성숙기 데이터가 착색도 0 - 70%, 성숙기의 80 - 90%의 착색도와 비교하여 그 특징을 추출하지 못해 학습이 제대로 이루어지지 않은 것으로 판단된다. 또한 성숙기, 과성숙기와 달리 미성숙기의 착색 범위를 넓게 적용하여 미성숙기 자체의 특징을 정의하지 못한 것으로 판단된다. 성숙기의 테스트 이미지(B, E, H)는 모두 꽃받기 부근이 덮이지 않은 이미지로 구성되어 있다. 따라서 작물의 생육 시기별 분류와 같이 과성숙기로 인식되는 것 없이 세 이미지 모두 98 - 99%의 정확도로 분류된 것으로 판단된다. 과성숙기의 테스트 이미지(C, F, I)는 단일 이미지 내 여러 딸기를 포함하고 있으며, 테스트 이미지 모두 하나 이상의 객체를 식별이 가능하였고, 작물의 시점이 위, 정면, 아래 등 모든 방향에서 인식되었다.

Conclusion

머신러닝 또는 기계학습은 인공지능의 한 분야로 데이터를 기반으로 학습하여 스스로의 성능을 향상시키는 시스템과 이를 위한 알고리즘, 빅데이터나 사물인터넷의 핵심 기술로 많은 분야에서 혁신을 주도하고 있다. 농가인구 감소와 농업인 고령화, 곡물자급률 하락, 농가소득 정체 등으로 곡물 생산의 효율성이 떨어지고 있는 실정에서, 농업분야 혁신을 꾀하기 위하여 정보통신기술 및 사물 인터넷기술을 접목한 스마트 팜에 관한 연구가 국내외로 활발히 이루어지고 있다. 본 연구에서는 농작물을 최고의 품질로 생산하여 수익성을 높이는 것이 중요하다는 점을 착안하여 딥러닝 기술을 이용하여 대상 작물인 딸기의 생육 시기별 이미지로부터 객체 추론(object inception)과 객체 검출(object detection) 방법을 활용하여 생육 시기를 판별하고, 학습 데이터양 및 학습 횟수에 따른 분류 정확도를 비교하였다. 기계학습 프레임 워크인 텐서플로우를 활용하였으며, 그 결과 작물 이미지가 생육 단계별 200개 이상이 되어야 분류가 가능하였고, 학습 횟수에 따른 생육 시기별 정확도는 다르지만 7,000회 이상이면 모두 분류가 가능하였다. 객체 검출 라이브러리를 활용하여 학습 횟수에 따른 딸기의 검출 및 생육 시기 분류를 진행하였으며, 미성숙기의 200개 학습 데이터로 학습하였을 경우, 학습 횟수 100,000회일 때 가장 적합한 것으로 나타났다. 본 연구의 결과는 향후 스마트 농장 관리 플랫폼 구축 및 최적의 수확시기 결정에 적용될 수 있을 것으로 판단된다.