Introduction

지난해 돼지 등급 판정 두수는 1,837만 두로 사상 최대를 기록하였고, 생산액은 쌀 다음으로 8조 4천 785억 원 규모로 추정된다(KAPE, 2022; KREI, 2023). 현재 국내 돈육 시장은 삼원 교잡종(Landrace × Yorkshire × Duroc, LYD)이 절대 다수를 차지하고 있다.

문제는 삼겹살(고지방)부위를 지나치게 선호하는 한국 소비자들의 입맛으로 인해, 삼겹살 부위와 일부 목살 부위를 제외하면, 한국 소비자들은 선호하지 않는(저지방) “비선호” 부위가 발생하고 있다는 것이다(예: 안심, 등심, 앞다리, 뒷다리). 한국보다 더 “느끼한” 맛을 선호하는 일본은 – 예로 최상의 마블링을 가진 등심 부위를 튀기고 우동에 넣어서 먹는 돈까스 우동 – 이미 미국 및 유럽형 종돈과 차별화된 등심 마블링에 특화된 상품을 이루었다. 즉, 해법은 시장의 다양성에서 찾아야 한다. LYD 시장이 주를 이루되 그 이외의 다른 가치를 더한 상품이 시장에 진입할 수 있는 가능성을 제시하고, 품질의 가치를 높일 수 있는(value added product)방법을 생산자들에게 공유하면, 직면한 다양한 위기 – 지구 온난화로 인한 기상 변화, 우크라이나 전쟁 및 인플레이션, 팬데믹 질병 등으로 인한 식량 안보 – 에 선제적 대응이 가능하다(Park et al., 2017b; Robbins et al., 2019).

현재 한국에서는 돼지를 야외 방목하는 것은 법적으로 허용되지 않는다. 미국 및 유럽의 경우, 야외 방목 돼지 생산은 소규모 농가들의 틈새 시장 전략과, 소비자의 공장형 농장 제품에 대한 반감, 친환경 및 동물복지의 유행에 힘입어 그 생산량이 꾸준히 증가하고 있고, 이에 대한 연구도 지속적으로 진행되고 있다(Choi et al., 2014; Park and Oh, 2017; Park et al., 2017a). 야외 방목 돼지 생산의 장점 중 하나로는 소규모 자본으로 농장을 운영할 수 있다는 것이고, 단점 중 하나는 돼지의 본능적인 습성인 굴토성으로 인해 지표 작물의 황폐화가 일어나고, 관리를 소홀히 할 경우 지하수의 과영양화가 발생할 수 있다는 것이다.

이에 USDA에서는 야외 방목 돼지 생산의 경우, 방목지가 지표 작물로 덮여 있는 비율을 75% 이상으로 정하고 있다(North Carolina Technical Note, 2007). 작물로 덮여 있는 면적을 정확히 계산할 수 없는 농가들로서는 전체 방목지를 고르게 방목하여 해당 면적을 유지한다고 하기 보다는, 희생 지역 또는 천막사를 두어 75%의 방목지에는 돼지를 방목하지 않고, 나머지 25%에 집중적으로 돼지를 사육하는 실정이고, 이것이 오히려 해당면적의 심한 훼손과 더불어 분뇨의 지하수내 유입 가능성을 높이고 있다(Pietrosemoli et al., 2012; Whitley et al., 2012a; 2012b).

최근 십수 년 동안 과학 기술의 발달로 다양한 이미징 도구와 기술이 개발되어 여러 제약 조건에서도 효율적으로 모니터링할 수 있게 되었고(Omari et al., 2020), 그 중 무인항공기(unmanned aerial vehicle, UAV)를 이용하여 사진을 촬영하는 것은 더 이상 고비용의 어려운 일이 아니다(Yun, 2017). 이러한 기술을 야외 방목 돼지 생산에서 방목지의 상황을 파악하는데 접목시킨다면 농가들이 목초지를 회복 불가능할 때까지 방치하지 않으면서, 권장되는 비율로 목초지를 유지하는데 많은 도움이 될 것이다. 또한, 돼지가 방목지를 훼손하면서 섭취하는 초지의 양이 얼마인지 가늠하기가 어려운데, 촬영된 사진의 색의 변화와, 미리 채취된 건물(dry matter)의 양을 비교하여 돼지가 해당 목초지에서 초지를 얼마나 소비하였는지 추정하는 것도 가능할 수 있다. 이 연구의 목적은 소형 무인기와 RGB 영상센서를 이용하여 야외 방목 돼지 생산에서 방목지의 훼손도를 정량적으로 예측하는 알고리즘을 개발하고자 하였다.

Materials and Methods

분석에 사용된 사진

분석에 사용된 사진은 노스캐롤라이나 A&T 주립 대학(Greensboro, NC, USA)내 돼지 농장(36°4′16.63″N, 79°43′33.02″E)에서 임신한 모돈 20두를 분만 예정일로부터 한달전에 야외에 방목하기 위해 50 m × 100 m 방목지 공간에 옥수수 작물을 조성한 방목지였다(IACUC: 12-003.0). 이 곳의 기후는 습한 아열대성 기후(Köppen 기후 분류)여서, 여름에는 아열대 기온을 보이고, 겨울은 온화하다. 연평균 강수량은 약 107 cm이다.

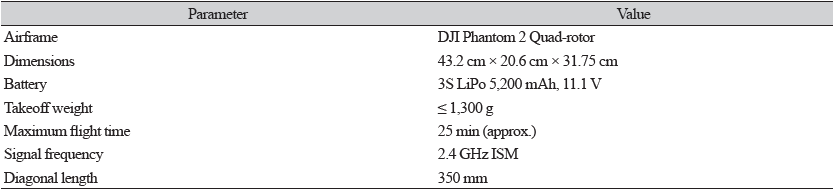

본 연구에서 사용하는 소형 무인 비행체는 DJI®社에서 제작된 Phantom 2 Vision 모델로, 프로펠러가 4개 달린 시스템(Quad-rotor System)이다(Fig. 1). 카메라를 포함하여 최대 이륙 중량은 1.3 kg이며, 5,200 mAh 리튬 폴리머 배터리를 사용하여 약 25분간 비행이 가능하다(Table 1). 반경 300 m까지 원격 조정이 가능하며 14 Megapixels의 1/2.3˝인치 크기의 고해상도 카메라 센서와 FOV 120°, 초점거리 28 mm 고정 초점식 광각 렌즈가 장착되어 있다. 자동 비행 조종 장치가 장착되었으며 이착륙 및 기체 수동 제어를 위해 2.4 GHz의 무선 조종기를 사용하였다.

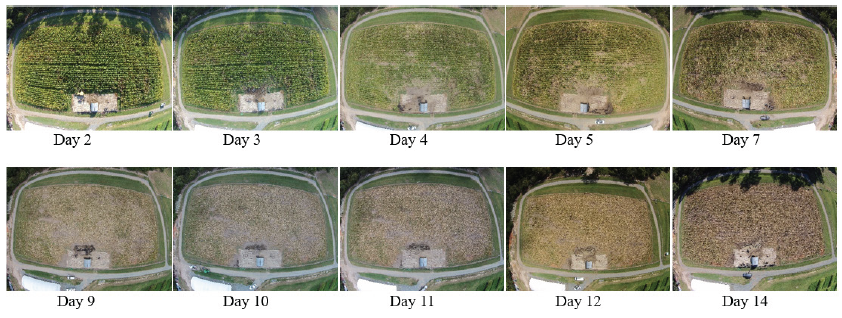

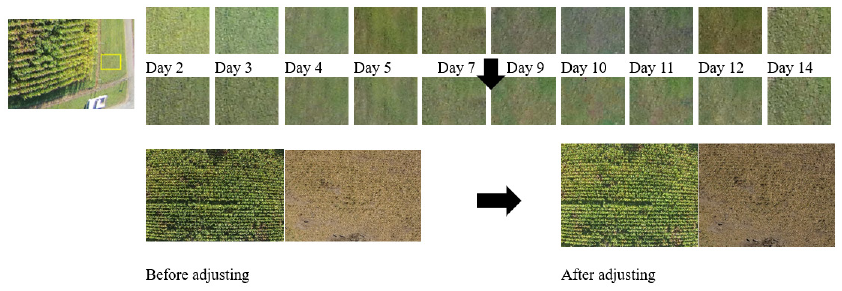

이 UAV를 이용하여 방목지가 한 장의 사진에 다 들어올 수 있는 높이에서 2015년 9월 1일부터 9월 13일까지 비 오는 날을 제외하고 10회 촬영하였고, UAV에 장착된 GPS를 활용하여 가능하면 동일한 높이와 위치를 유지하려고 노력하였다. 촬영시점은 해에서 비롯된 그림자 효과를 최대한 배제하고, 별도 조명이 필요 없는 아침 열 시 정도에 UAV가 운영가능한 환경 조건에서 진행되었다. Fig. 2는 돼지를 방사한 후, 2주간 UAV으로 촬영된 10장의 이미지를 나타낸다. 각 이미지 사이즈는 4,384 × 3,288 픽셀이다.

방목지 훼손도 측정 방법

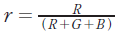

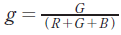

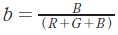

1) 원본 이미지의 RGB 값에서 녹색(Green)에 해당되는 값 비교

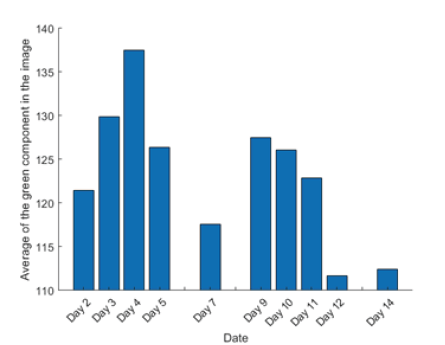

단순히 이미지 원본을 이용하여 RGB 값 중 녹색 값을 비교하였다.

2) 원본 이미지의 HSV 값에서 밝기의 평균 값을 모든 사진에 적용하여 RGB 값에서 녹색(Green)에 해당되는 값 비교

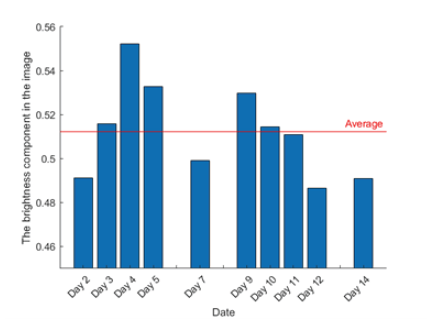

HSV은 색상(hue), 채도(saturation), 명도(value)로 색을 표현하는 방법이다(wikipedia.org). 방법 1)에서의 단점을 보완하기 위해서, 분석에 사용된 사진들의 HSV 값 중, 밝기 값들의 평균(131.17)을 모든 사진에 다시 적용하여 보정한 후, RGB 값 중 녹색에 해당되는 값을 비교하였다. Fig. 3는 분석에 사용된 사진들의 평균 밝기 값과 전체 사진의 평균 밝기 값을 표시하였다.

3) 원본 이미지의 HSV 값에서 밝기의 평균 값을 모든 이미지에 적용하여, 이미지의 R, G, B 수치 중 G(녹색) 성분이 가장 많은 픽셀 수를 합산하여 비교

모든 사진은 R과 G, B 세 장의 layer가 합쳐져 구성되고, 가장 기본 단위는 픽셀(pixel)이다. 이 픽셀마다 고유의 R 및 G, B의 수치가 존재하게 되는데, 각 픽셀마다 수치가 상대적으로 설정되기 때문에 전체 픽셀의 녹색 값만의 평균을 구하는 것이 무의미해질 수 있으므로, 각 사진 별로 G값이 나머지 두 개(R과 B)의 수치보다 더 큰 픽셀만의 개수를 합산하여 일별로 비교하였다.

4) 이미지 중 공통 영역의 HSV 값에서 밝기의 평균 값을 모든 사진에 적용하여 RGB 값에서 녹색(Green)에 해당되는 값 비교

방법 2)에서 실행된, 전체 그림의 밝기의 평균을 적용하는 것은 다소 기준이 모호하여 10장의 사진 중 특정된 공통 영역의 밝기는 같아야 한다는 점에 착안하여, Fig. 4와 같이 방목지 바깥 쪽에 있는 같은 영역을 지정하여, 10장의 사진에서 밝기를 구하고, 모든 사진에 그 평균을 적용하였다.

5) 이미지 중 공통 영역의 HSV 값에서 밝기의 평균 값을 모든 사진에 적용하여, 이미지의 R, G, B 수치 중 G (녹색) 성분이 가장 많은 픽셀 수를 합산하여 비교

방법 3)와 기본적으로 같은 과정이지만, 이미지 공통 영역의 HSV 값에서 밝기의 평균 값을 모든 사진에 적용하여 각 사진 별로 G값이 나머지 두 개(R과 B)의 수치보다 더 큰 픽셀만의 개수를 합산하여 일별로 비교하였다.

6) 원본 사진 중 옥수수 만 있는 영역만을 이용하여 공통 영역의 평균 밝기로 보정한 후, R, G, B 수치 중 G(녹색) 성분이 가장 많은 픽셀 수를 합산하여 비교

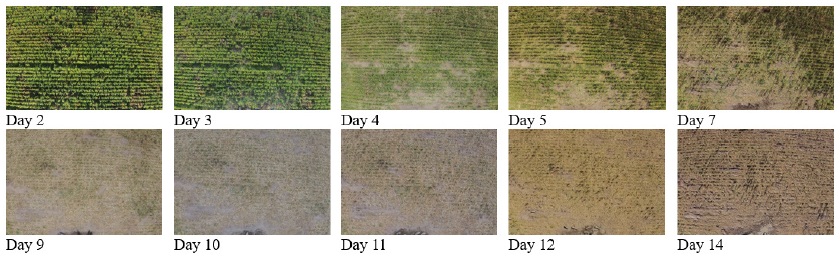

각 이미지내 옥수수만 있는 영역으로 잘라(Fig. 5), 방법 4)에서 설명된 Fig. 6과 같이 방목지 바깥 쪽에 있는 영역을 지정하여, 10장의 사진에서 같은 부분의 밝기를 구하고, 모든 사진에 그 평균을 적용하였다. 그 후 방법 5)와 같이 각 사진 별로 G값이 나머지 두 개(R과 B)의 수치보다 더 큰 픽셀만의 개수를 합산하여 일별로 비교하였다.

7) 원본 사진 중 옥수수만 있는 영역만을 이용하여 공통 영역의 평균 밝기로 보정한 후, EGI 방법을 적용하여 R, G, B 수치 중 G (녹색) 성분이 가장 많은 픽셀 수를 합산하여 비교

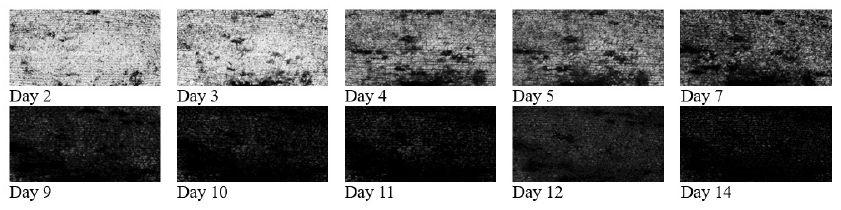

Woebbecke 등(1995)이 보고한 녹색 우월 지수(excess green index, EGI)를 Fig. 6의 사진에 적용하였다. Fig. 7은 EGI 방법을 적용한 10장의 사진을 나타낸다.

8) 원본 사진 중 옥수수만 있는 영역만을 이용하여 공통 영역의 평균 밝기로 보정한 후, VI 방법을 적용하여 R, G, B 수치 중 G (녹색) 성분이 가장 많은 픽셀 수를 합산하여 비교

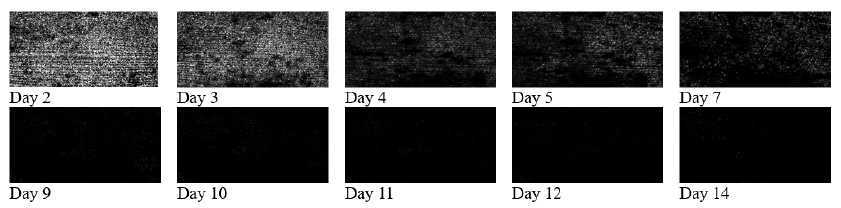

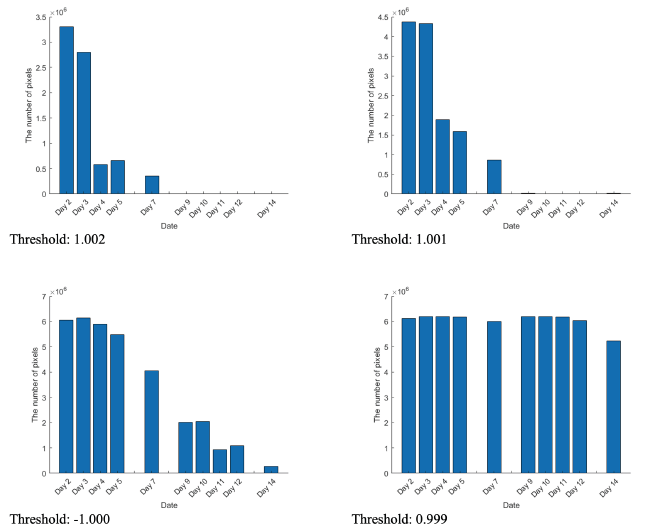

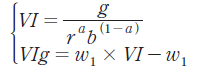

Hague 등(2006)이 보고한 식생 지수(vegetation index, VI) 방법은 본 연구의 방법 7)과 같이 원본 사진 이미지 중 옥수수만 있는 영역만을 잘라내어 공통 영역의 평균 밝기를 적용하여 사용하였다. VI를 사용하여 나타낸 사진은 사람의 육안으로 방목지의 상태를 인식할 수 없어, 가시성을 높이기 위해 식(1)과 같이 VIg로 변형하여 나타낸 사진이다(Fig. 8). 실제 실험은 VI 방법을 사용하였다.

(1)

(1)

여기서 ,

, ,

, ,

, ,

,  , 은 가시성 파라메터로 100으로 설정하였다.

, 은 가시성 파라메터로 100으로 설정하였다.

Results and Discussion

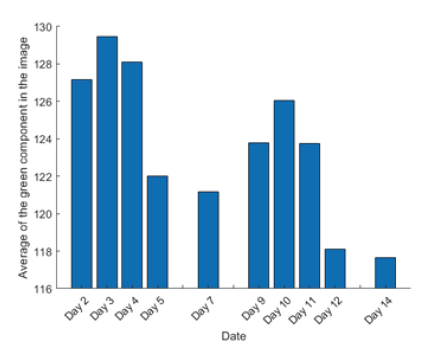

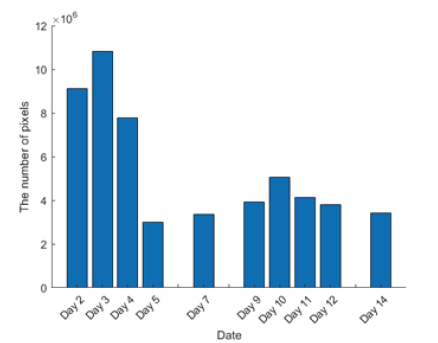

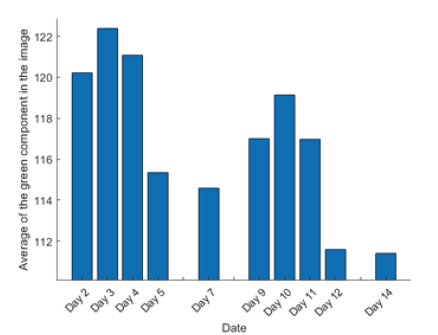

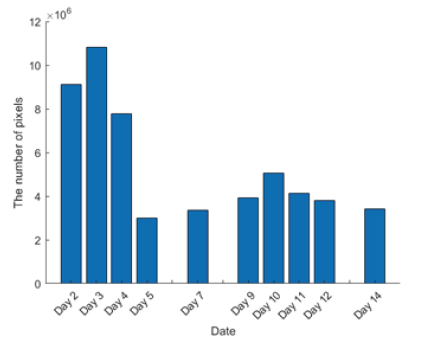

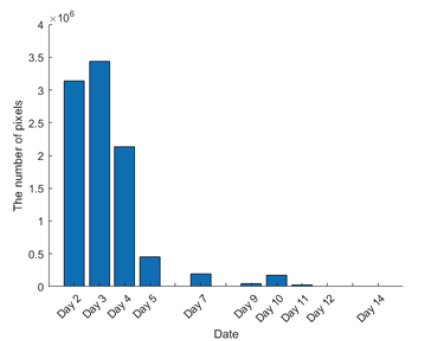

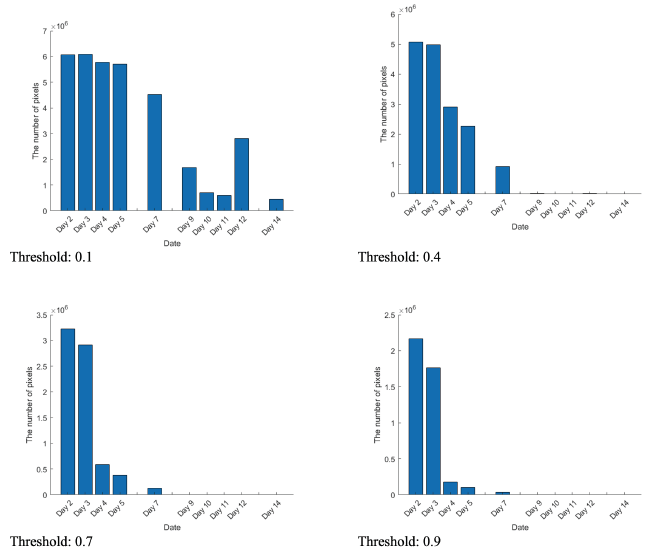

방법 1)은 날짜에 따른 방목지 훼손도의 함수 관계 도출이 어려웠다. 이유로는 촬영된 날짜에 따라 방목지에 드는 햇빛의 조도 량이 다르다. 이것은 사물의 색온도를 다르게 하여 카메라에서 재현된 영상 이미지의 색상은 전혀 다르게 나타난다. 또한 카메라의 설정 내부 파라메터들에 의해 동일한 환경 상태에서도 전혀 다른 느낌의 영상이 나타날 수 있다. 또한 그림자 및 외부의 요인에 의해서도 같은 색상이 다르게 나타날 수 있다. 그러므로, 단순 RGB 값으로 비교하는 것에는 한계가 있음을 알 수 있었다(Fig. 9). 방법 2)에서는 사용된 사진들의 평균 밝기로 사진을 보정하는 것이 RGB 녹색 값을 수치상으로 변화시키는 효과는 있었으나, 여전히 육안으로 볼 때 황폐화된 방목지를 설명하는 값으로 받아들이기에는 부족하였다. 단순 RGB 데이터만의 비교보다는 양호하나, 데이터 양의 부족으로 정확한 예측이 쉽지 않음을 알 수 있었다(Fig. 10). 방법 3)에서는 가장 문제가 되고 있는 9, 10, 11일째의 수치가 이전 분석 방법보다 현저하게 줄어들었지만, 12, 14일째 날짜는 매우 크게 증가하였다(Fig. 11). 여전히 육안으로 확인하는 방목지의 상태를 설명하기는 힘들어 보였다. 이것은 온전히 분석하려는 방목지 외의 지표 식물로 인한 것으로 생각되어, 분석 대상 영역이 아닌 지역은 제외하는 것이 합리적으로 보였다. 방법 4)를 통한 분석 결과, 방법 2)와 같이 전체 영역에 대한 평균 밝기(brightness)를 적용하는 것과 유사한 결과를 보였다. 공통 영역 사진들의 평균 밝기로 사진을 보정하는 것이 RGB 녹색 값을 수치상으로 변화시키는 효과는 있었으나, 여전히 육안으로 볼 때 황폐화된 방목지를 설명하는 값으로 받아들이기에는 부족하였다. 이를 통해 녹색(green) 데이터만의 비교 만으로는 방목지의 훼손도의 정확한 예측이 쉽지 않음을 알 수 있었고, 사진에 찍힌 방목지 주변의 녹색 값이 존재하기 때문에, 주변 데이터 삭제가 필요함을 알 수 있었다(Fig. 12). 방법 5) 역시 방법 3)과 큰 차이를 보이지는 않아 방목지 외의 주변 데이터가 많은 영향을 미치는 것을 알 수 있었다(Fig. 13). 방법 6)에서는 원본 이미지 중 옥수수 만 있는 영역만을 이용하여 공통 영역의 평균 밝기로 보정한 후 R, G, B 수치 중 G (녹색)성분이 가장 많은 픽셀 수를 합산하여 비교한 바, 합리적인 훼손도를 볼 수 있었다(Fig. 15). 방법 7)은 Woebbecke 등(1995)이 제안한 EGI 방법을 적용하고, 임계 값을 0.1, 0.4, 0.7, 0.9로 설정하였을 때 각 사진에서 임계 값보다 큰 픽셀 수를 나타낸다(Fig. 15). 임계 값이 0.4와 0.7의 경우, 훼손도(식생 지수)를 가장 잘 추정하는 것으로 나타난다. 그러나 임계 값이 0.1인 경우, 2 - 5일째까지 크게 변화가 없다가 급격하게 줄어들며, 12일째의 값이 갑자기 증가함을 알 수 있다. 정확한 훼손도를 추정하기 위해서는 EGI 방법의 적절한 임계 값 설정이 요구된다. 방법 8)은 Hague 등(2006)이 제안한 VI 방법을 사용하여 임계 값을 1.002, 1.001, 1.000, 0.999로 설정하였을 때의 결과이다. 임계 값이 1.001일 때 훼손도(식생 지수)를 가장 잘 추정하는 것으로 나타난다. 임계 값의 범위가 너무 작아 정확한 임계 값을 추정하는 것이 EGI 방법보다 매우 어렵다(Fig. 16).

UAS (Unmanned Aerial Systems)는 넓은 적용범위와 구조 및 크기가 다양한 형태로 제공되며, 원격 제어가 가능하거나, GPS 기반의 소프트웨어 제어 비행 계획을 통해 자율적으로 비행할 수 있는 항공기다. UAS는 네비게이션 시스템이나, RGB 카메라, 적외선 카메라 등과 같은 다양한 기록 장치들을 내장할 수도 있다. UAS 사용의 진보 중 일부는 가볍고, 운반이 용이하며, 고해상도 및 저비용의 이미지를 캡처하고, 데이터 수집 요구 사항에 따라 다양한 고도에서 비행할 수 있으며, 자동차, 보트 등이 접근할 수 없는 영역을 이동할 수 있다. 또한, 구조 작업, 의약품 및 식품 전달, 위기 상황에서의 의사 소통, 원시 데이터의 신속한 가용성 등을 제공한다(Simelli and Tsagaris, 2015).

무인 항공기(UAV)는 정밀 농업에 사용되는 이러한 기술 발전을 나타낸다. Lee 등(2021)은 옥수수 질병으로 인한 수확량의 피해를 줄이기 위해 이상을 조기에 탐지하는 정보 제공 시스템으로써 UAV을 활용한 딥러닝 기법으로 옥수수 경작지 분석한 바 있다. UAV 촬영 영상과 GPS데이터를 서버로 전송하였고, 영상을 0.1초 단위 프레임으로 나눈 후, 미리 학습시킨 모델로 이상을 확인하였다. 이들 역시 모델을 학습시키기 위해서는 많은 이미지 자료가 필요하다고 서술하였고, 한계점으로는 옥수수에만 적용이 가능한 점을 들어 향후 다양한 식물의 데이터를 학습시킬 필요가 있다고 보고하였다. Parra 등(2021)은 콩류 작물의 평가하는 방법론을 제시한 바 있다. 이 연구에서는 다른 3개의 고도(높음, 보통, 낮음)과 2개의 종(병아리콩와 렌즈콩)을 포함하였다.

무인항공기는 높은 이미지 해상도의 위성 및 공중 센서에 비해 강력한 이점이 있다(Jannoura et al., 2015). UAV를 이용한 정밀농업은 생산의 증가, 효율성의 향상, 수익성의 향상, 환경영향의 감소 및 정량화 가능한 데이터의 가용성 등이 제공하는 이점의 일부이다(Herwitz et al., 2004). 그러나, 유용성에 대한 의문이 제기되는데, 촬영된 사진에 관한 한 UAV의 효과에 관한 질문은 다양한 기후 환경으로 인해 이미지 품질이 균일하지 못하다는 것과 이로 인한 데이터의 무결성 및 분석에 대한 문제이다. 따라서, 카메라의 고도, 노출 설정, 스펙트럼 반응성, 태양의 광도 및 고도 등을 고려하여 사진을 보정해야 하는데, 위 요인을 모두 고려하여 보정하면 부정확한 모델링 데이터에 의한 오차가 누적되어 결과적으로는 부정확한 결과로 이어질 수 있다(Yun, 2017).

Yun (2017)은 EGI 값을 기준으로 무, 배추 생육과 흙, 비닐의 배경을 나누는 문턱 값을 결정하여 작물 재배 영역을 구분하였으나, 이 연구에서는 모돈이 파헤쳐 놓아 만들어진 흙과 아직 살아있는 옥수수의 경계가 모호하여 단순히 문턱 값을 적용하는 것은 적절하지 않았다. Kim 등(2015)은 작물과 배경의 분리 정확도를 개선하는 방법으로 Otsu (1975)의 문턱 값 계산 방법과 삼각 문턱 값 계산법(triangle method)의 복합적 사용을 보고한 바 있다.

현재 농작물의 원격 감지에서 식생 지수의 대부분은 적색, 녹색 및 청색 스펙트럼 대역을 사용한다(Meyer and Neto, 2008). Torres-Sánchez 등(2014)이 연구한 바에 따르면, EGI, VI 방법 등의 다양한 식생 지수를 무인기에 장착된 RGB 카메라에서 촬영된 가시광선 영상에 적용해 본 결과, EGI 방법과 VI 방법이 식생 피복률을 가장 높은 정확도로 추정하였다고 보고하였다. Jannoura 등(2015)은 완두콩과 귀리가 있는 밭에서 작물 바이오매스를 평가하는 연구를 수행하였는데, 원격조종 헥사콥터에 장착된 RGB 디지털 카메라를 사용하여, 항공사진을 바탕으로 표준화된 녹색-적색 차이 지수를 계산하여, 지상 바이오매스 및 잎 면적 지수와 연결지었다. 이 연구에서는 녹적 식생지수, 정규화 차이 식생지수, 가시 식생지수도 계산하였다.

최근 연구의 결과는 실제 색상 이미지가 전체 필드의 작물 변동 상황을 결정할 수 있음을 보여준다. 낮은 운영 비용을 고려할 때 소규모 필드 영역에서 현장별 정밀 농업을 위한 도구로서 UAV를 사용한 이미지 분석 방법의 개발은 필수적이다. 생산자들에게 신뢰할 수 있는 정보를 제공하기 위해서는 플랫폼 설계의 발전이 필요하며, 농장 경영 의사 결정에 신뢰할 수 있는 도움을 얻기 위해서는 이미지 해석 및 분석에 적극적으로 참여할 필요가 있다(Simelli and Tsagaris. 2015).

Conclusion

UAS를 통해 얻어지는 이미지는 셀 수없이 양산되고 있다. 이미지 분석을 통해 작물의 생산량을 추정하기 위해서는, 촬영 시 UAS의 동일 고도 및 조도와, 사전에 수집된 작물의 성장 정보가 전제되어야 한다. 이 연구에서는 경작지 또는 방목지의 피복율에만 집중하여 이미지 분석을 하였고, 이를 통해 피복율의 변화를 상대적으로 쉽게 구하는 방법을 살펴보았다. 기존에 보고된 방법은 문턱 값에 따라 결과가 달라지기 때문에 여러 수치를 비교해야 했지만, 원본 사진 중 옥수수 만 있는 영역만을 이용하여 공통 영역의 평균 밝기로 보정한 후, R, G, B 수치 중 G (녹색) 성분이 가장 많은 픽셀 수를 합산하여 비교한 것은 계산 그 자체로 피복율을 알 수 있었고, 사용된 여러가지 방법 중 상대적으로 가장 효율적인 추정법이었다.