Introduction

4차 산업혁명 이후 농업 분야에서 기계화 및 자동화가 발전되어 상용화에 이르고 있는 가운데 아직까지 과수업 분야에서는 미흡한 실정이다. 이는 과수의 종류에 따라 작물의 물리적 특징과 재배 환경이 다르다는 것에서 기인한 것으로, 그 중 사과는 수확 후 상품성이 없는 흠과를 선별하는 과정에 아직까지 사람의 육안으로 이루어지고 있는 등 기계화의 정도가 미흡한 형편이다. 장시간에 걸친 육안 선별 작업은 작업자들의 근골격계 질환 유발과 더불어 많은 노동력을 요구하고 있기 때문에 기계화 및 자동화에 대한 요구가 크다.

사과 선별에는 각 과실의 크기, 무게, 형상, 색깔, 상처 유무 등 과일의 품질을 결정지을 수 있는 많은 요인이 작용한다(Yoo et al., 2022). 이러한 많은 요인을 육안에 의존하여 선별할 경우 선별 결과에 오류가 발생할 가능성이 높으며 이는 과일의 상품성 평가에 치명적인 약점으로 작용할 가능성이 높다. 또한 현재 사과 선별 결과 흠과 발생률은 약 14.1%인 것으로 보고되고 있는데(Jeong and Yang, 2021), 선별 과정을 정교하게 하여 기계화 및 자동화가 이루어진다면 흠과 선별의 정확도를 높일 수 있을 것으로 기대된다.

Choi 등(2000)은 영상처리 과일 선별 시스템과 근적외선을 이용한 비파괴 당도 판정 시스템을 조합한 시스템을 개발하여 사과의 당도, 색깔, 무게 등 내외부품질의 실시간 판정성능을 평가하였다. So 등(2013)은 기존 중량 과일 선별기 제품에 화상 처리 시스템을 탑재하여 화상 처리를 이용한 과일의 색상 선별 시스템을 개발하였다. 개발된 시스템의 성능을 검토한 결과, 선별 정밀도가 ± 2%로 높은 정밀도를 확인할 수 있었다. Kim과 Lim (2021) 은 농산물 산지 유통 센터에서 설치되어 사용하고 있는 비파괴 과일 선별 시스템을 이용하여 정상 사과와 내부에 결함이 있는 사과를 판별하기 위한 최적 파장과 해당 스펙트럼의 특성을 구명하였다. Kim (2022)은 과일의 시각적 특징을 효과적으로 추출하고 등급을 분류할 수 있는 convolutional neural network (CNN) 모델과 물리적 특징으로 크기와 무게를 이용하여 과일의 등급을 분류하는 퍼셉트론을 제안하였다. Lee 등(2022)은 자동 선별기 구축을 위해 딥러닝 기반의 사과 품질 분류 모델을 제안하였다. 제안된 모델은 94.7%의 정확도를 달성하고, 임베디드 환경에서 한 장당 0.24초의 판별속도를 보여주었다.

사과의 색깔, 무게, 당도 등을 분석하여 사과의 등급을 분류하기 위한 연구는 활발히 진행되었지만, 딥러닝 기술을 이용하여 선별과정에서 흠과를 자동으로 선별하는 연구는 상대적으로 매우 부족하다. 현재 농가에서는 일손 부족으로 흠과를 직접 선별하지 않고 대부분 산지공판장 또는 농협 수매장에 무선별품을 출하하고 있다. 이는 불필요한 비용이 사용되어 농가에 부담을 주기 때문에 사과 수확 단계에서 흠과를 선별함으로 인해 불필요한 물류비를 줄일 수 있는 시스템이 필요하다. 이를 위해 본 연구에서는 인공지능의 한 분야인 머신 러닝 기술을 활용하여 사과 선별 시스템을 개발하였다. 머신 러닝은 대규모 데이터를 처리할 수 있기 때문에 많은 양의 사과 이미지를 학습하여 사과의 흠집 여부를 구분하는데 유용하다. 또한 실시간으로 데이터를 처리할 수 있으므로 사과 선별기에 투입 시 선별과정을 실시간으로 모니터링이 가능하다는 장점이 있다.

농업의 디지털화를 통한 생산성 향상은 수출의 증가와 밀접한 연관이 있다는 것은 널리 알려져 있다(Youm et al., 2022). 국내의 경우 농업 경쟁력 강화를 위해 센서, 자동화 관련 ICT (information and communications technology) 기술 도입을 위한 연구가 많이 이루어졌지만, 디지털 기술 도입에 초점을 맞춘 연구는 상대적으로 미흡한 실정이다. 본 연구는 농업에 디지털 기술 도입에 따른 효과를 분석했다는 점에서 의의가 있다고 할 수 있다.

Materials and Methods

사과 선별 장치

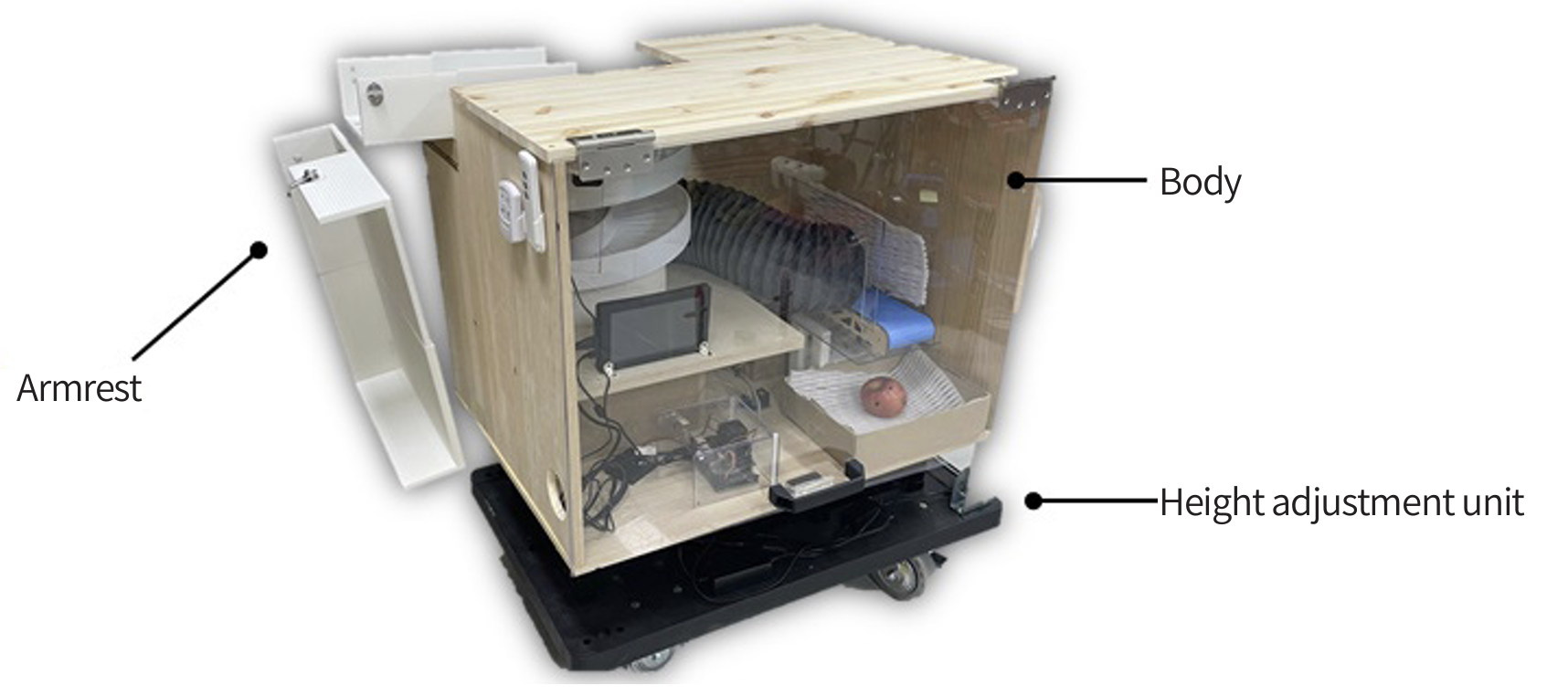

Fig. 1은 본 연구에서 사용한 사과 선별 장치이다. 본 장치는 팔 받침대, 본체, 높이 조절부로 구성되어 있다. 팔 받침대는 사과 수확 시 작업자가 팔을 거치할 수 있는 거치대로서 산업통산자원부 국가기술표준원에서 제공하는 인체 표준 정보를 참고하여 길이 500 mm, 폭 400 mm로 제작되었다. 팔 받침대는 사과 수확에 투입되는 작업자로 예상되는 30 - 60대 남성의 평균 어깨 넓이, 팔의 간격 길이를 기준으로 하였다. 또한 작업자의 편의를 위해 회전이 가능하고, 접이식이 가능하도록 제작하였다.

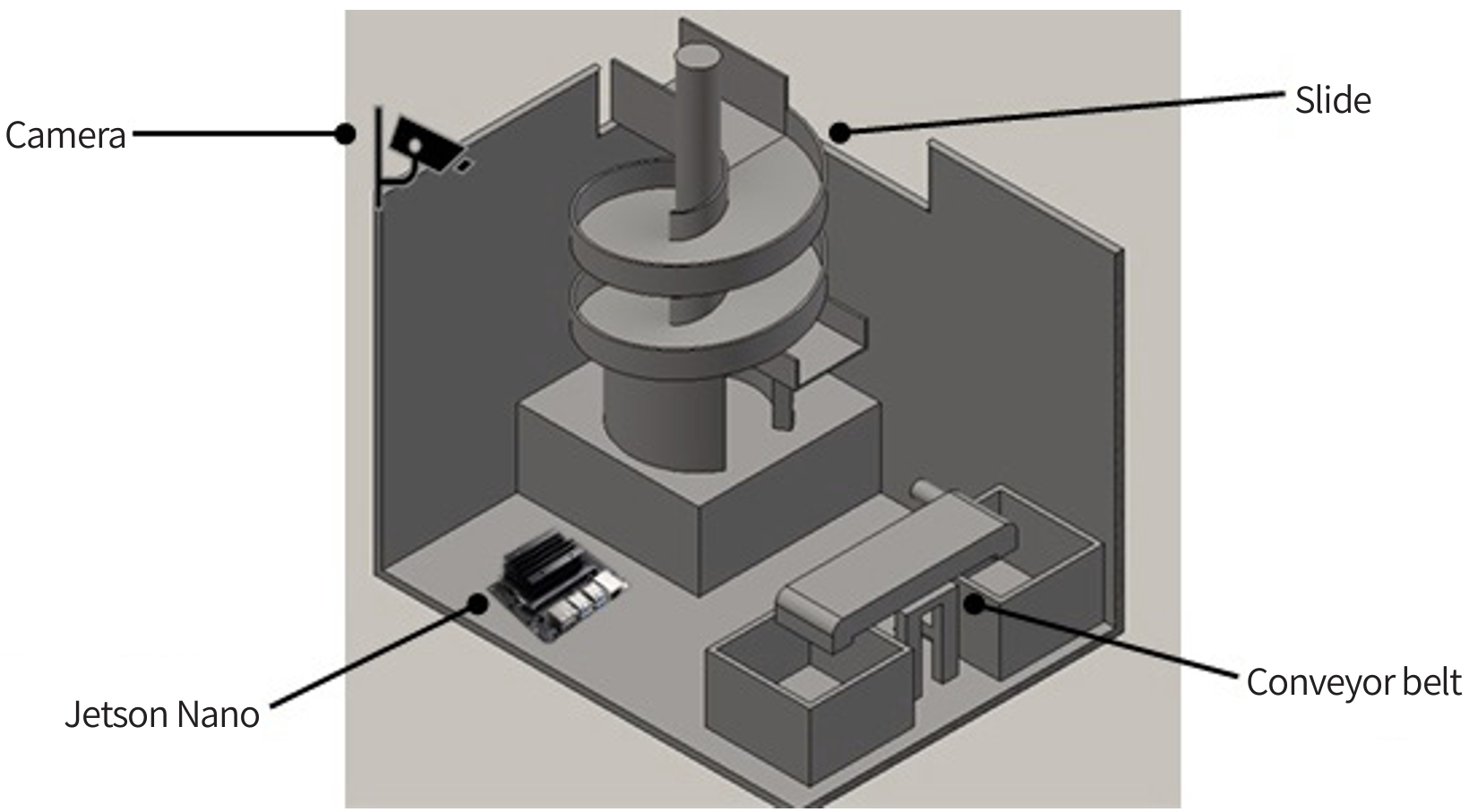

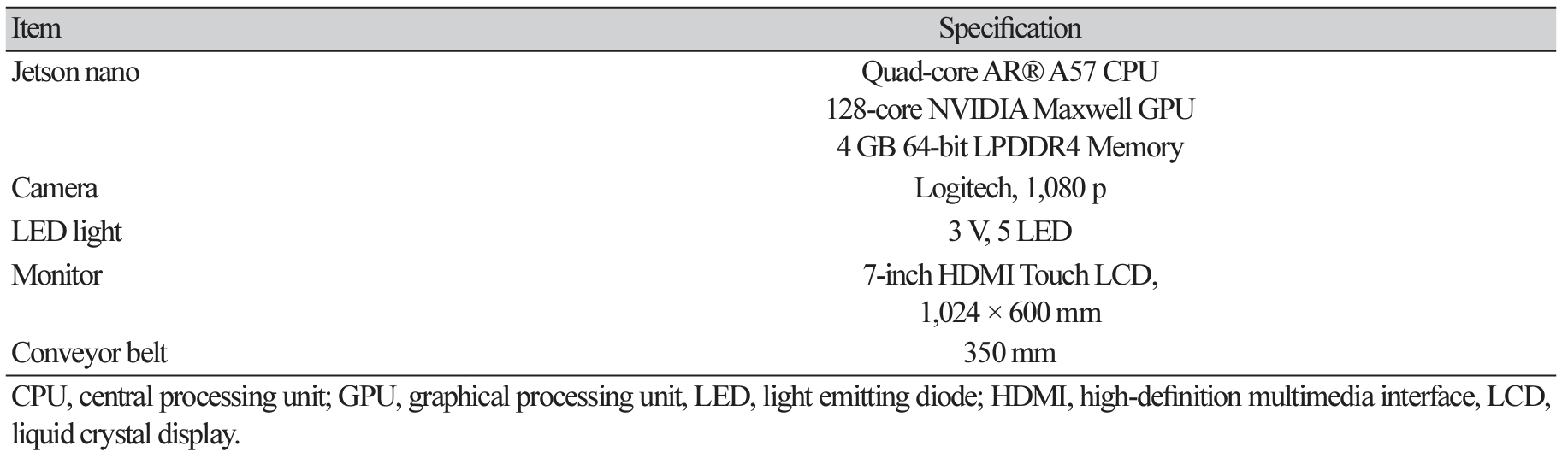

본체는 목재집성판으로 길이 840 mm, 폭 625 mm, 높이 630 mm로 제작되었다. Fig. 2는 본체 내부의 구성도를 나타낸 그림이며, Table 1에서 본체 부속품의 제원을 정리하였다. 나선형 슬라이드는 팔 받침대에서 굴러온 사과를 선별하고 컨베이어 벨트까지 무동력으로 사과를 전달하는 역할을 한다. 카메라는 본체 천장에 부착되어 있으며, 나선형 슬라이드 상부에서 사과가 굴러가는 동안 이미지 촬영이 이루어진다. 한 대의 카메라로 사과 선별 시스템 구축이 가능하다면 구축에 소모되는 비용과 시간을 줄일 수 있으므로 본 연구에서는 한 대의 카메라로 실험이 진행되었다. 습득된 이미지는 젯슨 나노(NVIDIA Corporation, USA)를 통해 정과 및 흠과의 이미지 분석이 진행된다. 젯슨 나노는 임베디드 컴퓨팅 보드로 graphical processing unit (GPU) 기반으로 딥러닝 및 이미지 분석 등에 특화되었으며, 영상처리에 탁월한 성능을 보인다. 이미지 분석이 완료된 사과는 덕트를 거쳐 컨베이어 벨트를 통해 각각의 정과 및 흠과 박스로 이송된다.

높이조절부는 본체 하단에 상하 높이조절이 가능한 전동 리프트를 장착하여 작업자 신체에 맞게 팔 받침대의 높이를 조절할 수 있도록 제작하였다. 리프트의 최대 높이는 680 mm로써 선별 작업이 끝난 후 작업자가 허리 구부림을 최소화하여 정과 및 흠과 박스를 트럭 적재함으로 적재할 수 있도록 설계하였다.사과 선별 알고리즘 구현

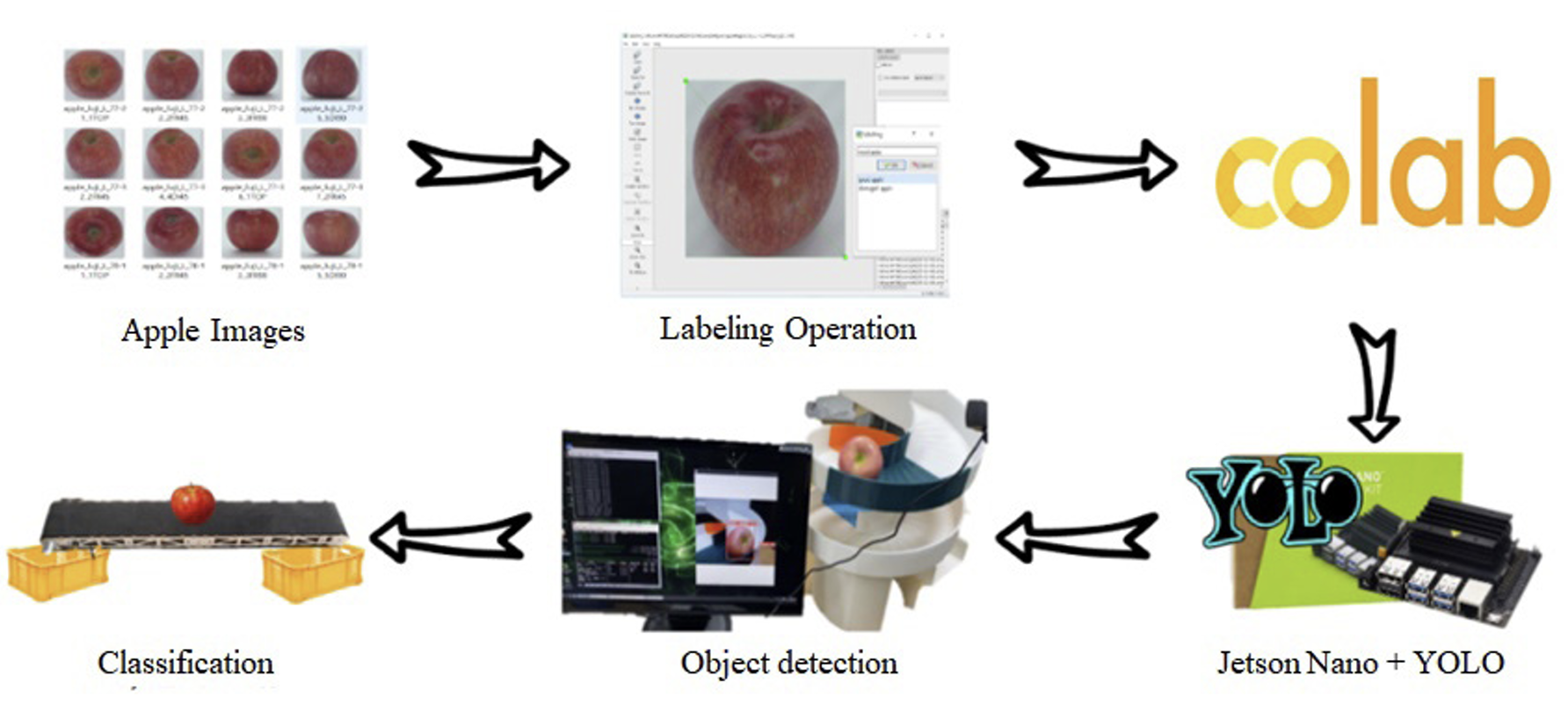

본 연구에서 사용된 사과 선별기의 시스템은 Fig. 3에서 도식화한 과정에 따라 작동된다. 우선 정과와 흠과의 이미지 데이터를 수집하고, 이를 대상으로 라벨링 작업을 수행하여 데이터 셋을 구축하였다. 이후 구글 코랩과 YOLO (YOLOv5, Ultralytics Inc., USA) 딥러닝 모델을 활용하여 데이터를 학습시켰다. 학습된 데이터는 젯슨나노를 이용하여 이미지 분석이 수행되도록 선별 알고리즘을 구현하여 최종적으로 흠과 사과를 검출하는 시스템을 구축하였다.

객체 인식을 수행하는 딥러닝 알고리즘에는 You Only Look Once (YOLO)와 region-based convolutional neural network (R-CNN) 등이 있다. YOLO 모델은 One-stage-detection 방법을 고안하여 실시간으로 객체 인식이 가능하게 만들어졌으며, R-CNN 모델과 달리 한 장의 이미지를 여러장으로 분할하고 이미지를 분석하는 과정 없이 이미지를 한 번만 보는 특징을 가진다. 또한 전처리모델과 인공신경망이 통합되어 실시간으로 객체를 탐지할 수 있어 R-CNN 모델보다 훨씬 빠른 성능을 보이기 때문에 본 연구에서는 사과 선별 모델로 YOLO를 채택하였다.

사과 이미지 데이터 학습

정과 데이터는 AI Hub (2020)의 농산물 품질 이미지를 통해 수집하였다. 수집 이미지는 후지, 양광 2개의 품종을 대상으로 3가지 등급으로 구분하여 각 100장씩 총 600장을 확보하였다. 후지와 양광은 각각 고유한 특성을 가지는 두 가지 다른 사과 품종이다. 이러한 이유로 딥러닝 모델이 품질을 정확히 판별할 수 있도록 두 가지 품종을 분류하여 학습을 수행하였다. 이미지 내 3개 등급은 국립농산물품질관리원에 공개되어 있는 기준표를 토대로 특, 상, 보통 3개의 등급으로 구분하였다. 흠과 이미지 데이터는 인공지능 허브에서 이미지를 구할 수 없을 뿐만 아니라, 인터넷 상의 흠과 이미지는 촬영 환경이 일정하지 않기 때문에 학습 데이터로 사용하기에 적합하지 않았다. 따라서 일정한 촬영 환경을 구현한 뒤 흠과를 직접 촬영하여 데이터를 확보하였다. 이는 일정한 위치에서 정면, 위, 대각 3가지 방향에서 각 100장씩 촬영하여 총 300장을 확보하였다.

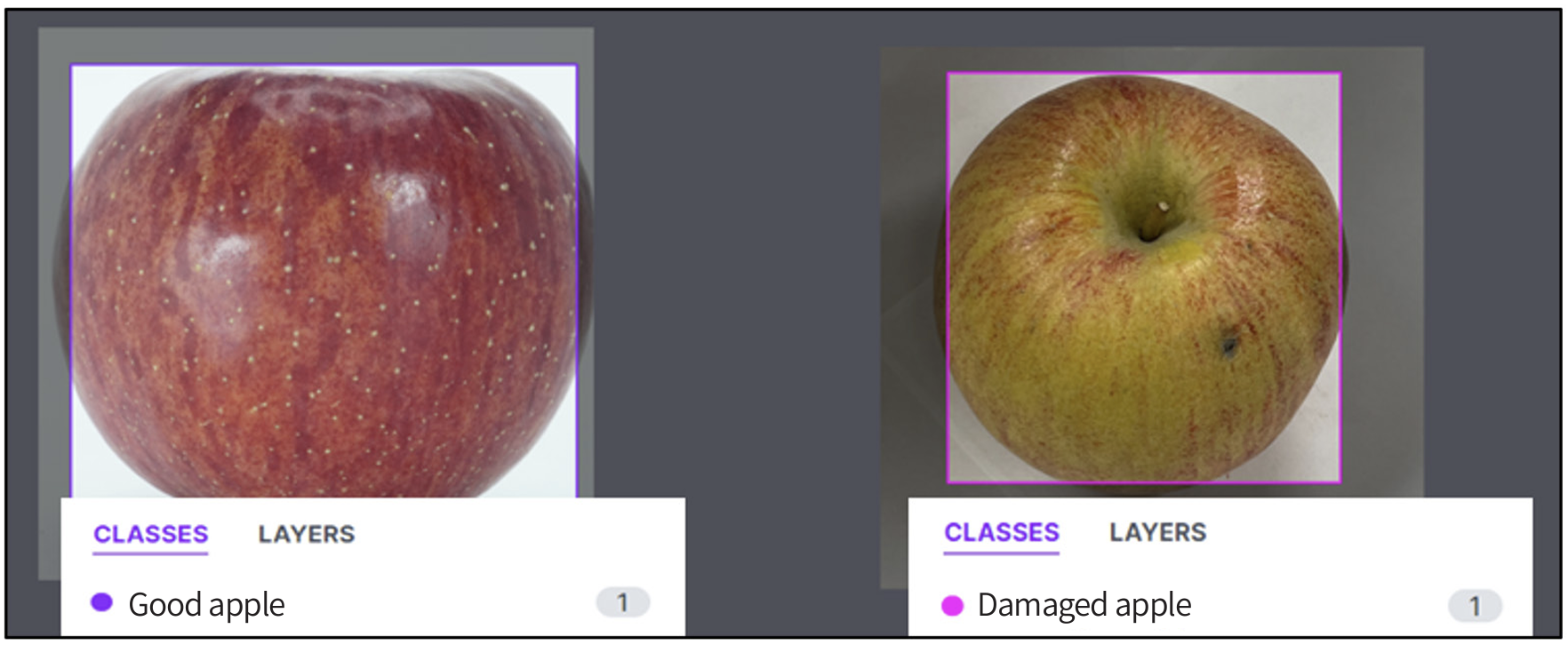

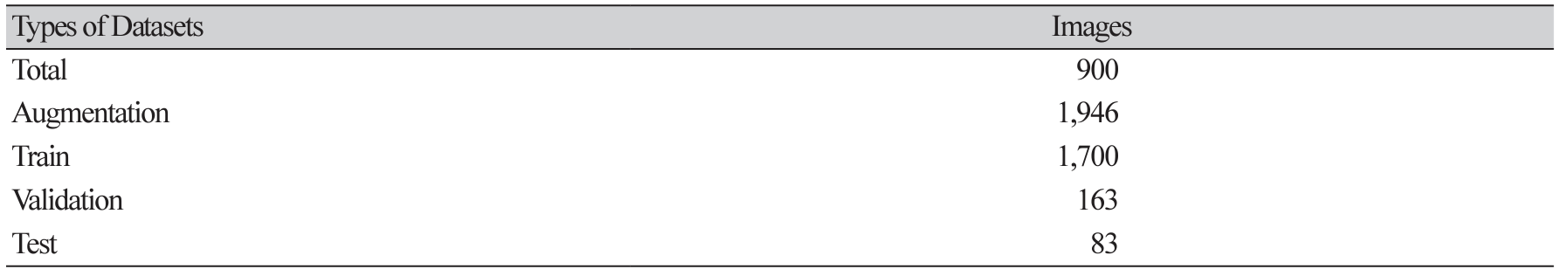

이렇게 확보한 데이터는 Roboflow (Roboflow Inc., USA)를 통해 정과(good apple)와 흠과(damaged apple)로 class를 분류하여 라벨링 작업을 수행하였으며, 딥러닝 후 검증을 위해 데이터를 7 : 2 : 1 비율로 Train/Validation/Test set으로 나누어 주었다. 여기서 Train set은 딥러닝 모델을 학습하기 위한 데이터, Validaion set은 일반적인 패턴을 학습하기 위한 데이터로 새로운 데이터를 예측하는데 사용된다. Test set은 모델이 학습한 패턴을 평가하기 위한 데이터를 의미한다. 부족한 사과 이미지 데이터는 Flip과 Rotation 기능을 이용하여 이미지 양을 2,000장으로 늘려 학습시킨 뒤 설정된 값으로 데이터 셋을 생성하였다. Fig. 4 및 Table 2는 Roboflow를 이용하여 데이터 라벨링을 진행하고 데이터 셋을 구현한 그림이다.

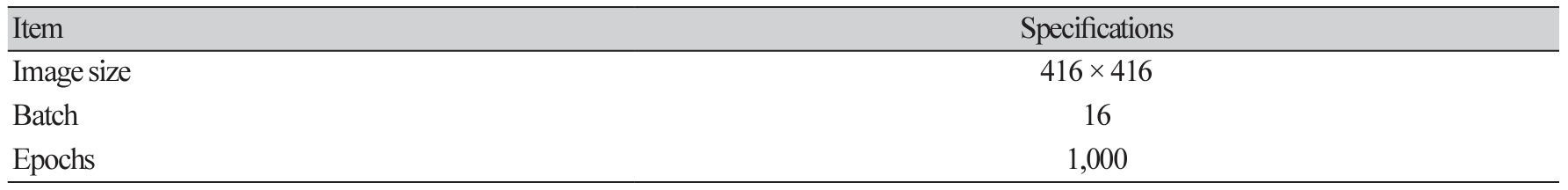

구글코랩에서 생성된 데이터 셋을 이용하여 딥러닝 학습을 위한 YOLOv5를 실행하였다. 학습을 위해 이미지 목록들을 txt파일로 변환하여 리스트를 생성하였으며, 학습에 사용한 이미지 제원은 Table 3에 정리하였다. 학습 결과 과적합 방지를 위해 412번째에서 학습이 종료되었으며, 이 때 생성된 최적의 가중치 파일을 다운로드하여 실시간 객체 검출에 적용하였다.

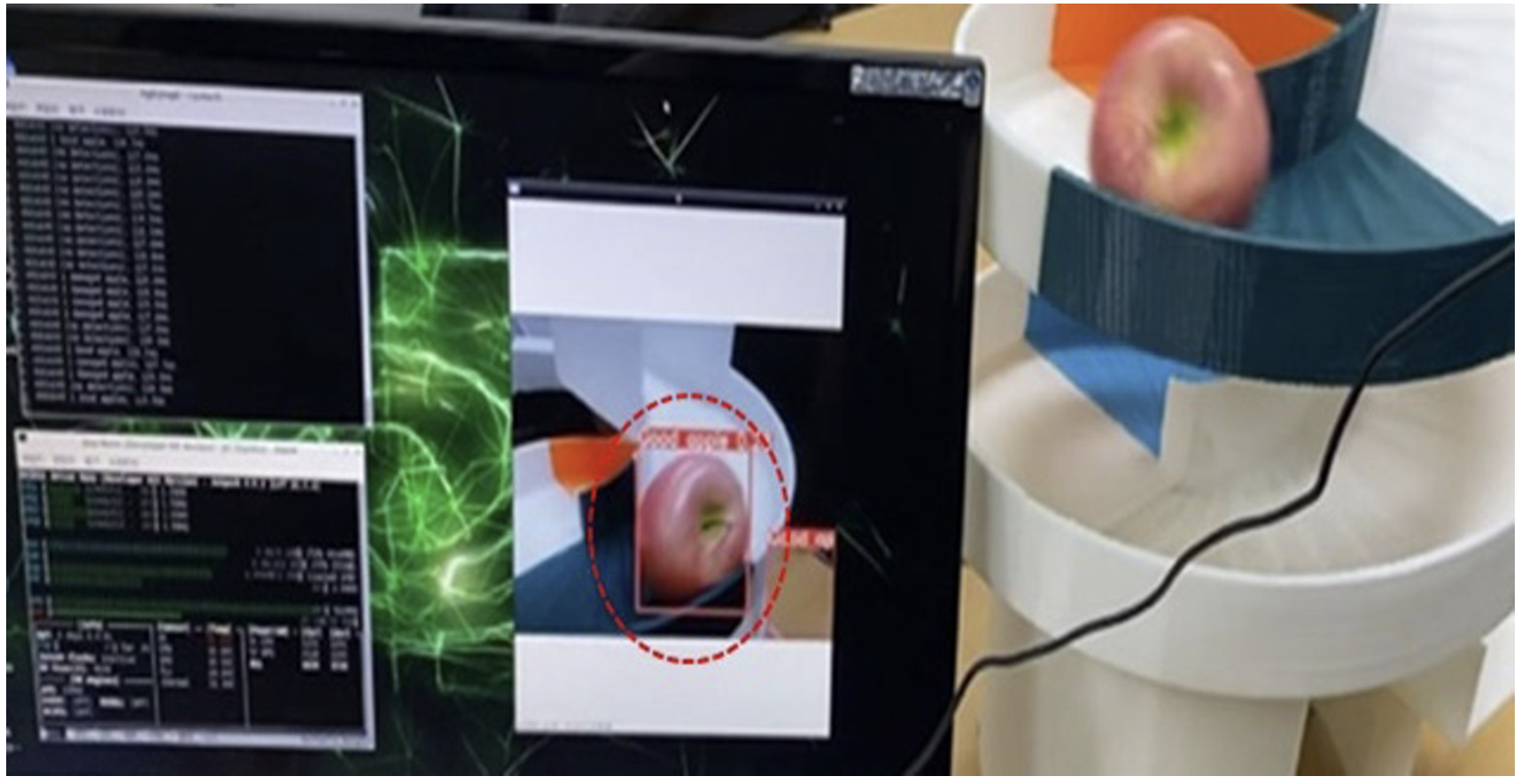

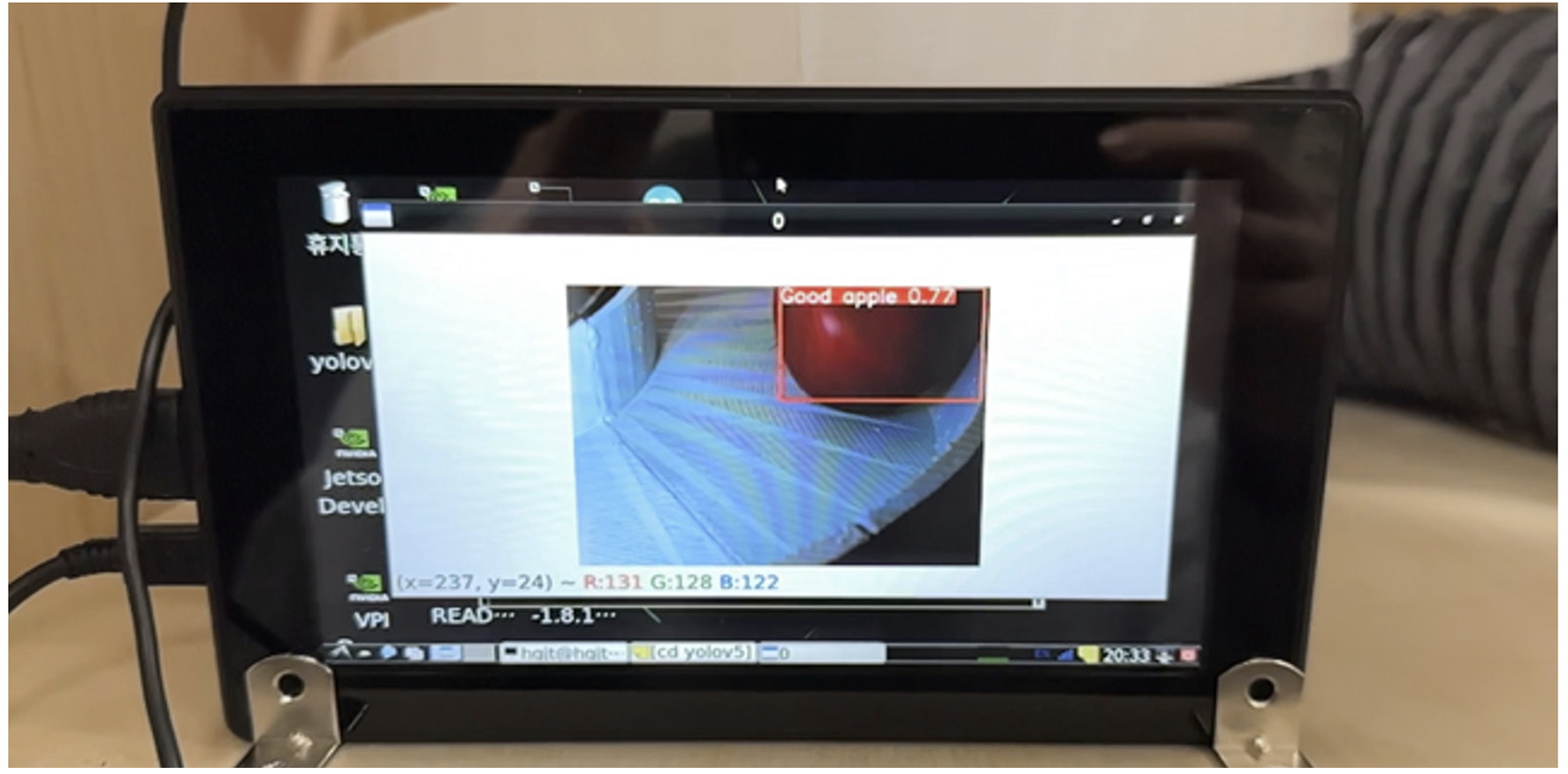

데이터 학습을 마친 뒤 젯슨 나노의 환경을 구현하기 위해 Ubuntu (22.10, Canonical Ltd., UK) 및 영상처리 오픈소스 라이브러리 OpenCV (4.6.0, Intel, USA)를 설치하며, GPU 사용을 위한 PyTorch (2.0.0, Meta Platforms Inc., USA)와 PyTorch 패키지인 Torchvision을 설치해준다. Torchvision은 다양한 종류의 내장된 데이터셋(built-in datasets)과 편리한 유틸리티 클래스(utility classes)를 제공한다. 이후 다운로드한 가중치 파일의 경로를 지정하고 젯슨 나노와 카메라를 연결한 뒤 YOLOv5를 실행하여 사과의 실시간 객체 검출을 진행하였다. Fig. 5는 나선형 슬라이드에서 사과가 굴러갈 때 정과로 객체 인식이 진행된 모습이다.

젯슨 나노와 컨베이어 벨트 연동

이미지 판별 후 사과를 정과 또는 흠과로 분류하여 각각의 상자에 담기 위해 젯슨나노와 컨베이어 벨트를 연동하였다. 본 연구에서는 젯슨 나노의 general-purpose input/output (GPIO) 제어를 활용하여 별도의 추가 장비 없이 컨베이어 벨트의 direct current (DC)모터를 제어하는 알고리즘을 구현하였다. 이 알고리즘은 YOLO의 객체 검출 정확도에 따라 DC모터의 방향을 제어하여 컨베이어 벨트를 작동시킨다. 객체 검출 정확도는 두 가지 단계로 측정된다. 먼저, 사과가 나선형 슬라이드를 통과할 때 입력된 이미지를 바운딩 박스를 통해 확인하고 학습된 데이터와 비교하여 정과 및 흠과의 객체 인식이 이루어진다. 두 번째로, 객체의 종류를 올바르게 인식했는지에 대한 식별 정확도를 백분율로 나타낸다. 투입된 사과의 객체 검출 결과가 정과로 인식되면 컨베이어 벨트를 정방향 제어, 흠과로 인식되면 역방향 제어를 수행하여 각각의 사과박스로 이송되게 하였다.

Results and Discussion

조명과 그림자의 영향으로 카메라에 인식되는 사과의 색이 변하는 경우, 객체검출 정확도 0.3 미만은 정과를 흠과로 오검출 되는 경우가 빈번히 발생하였다. 따라서 사과의 객체 검출 정확도를 0.3 이상으로 설정하였다. 스레드 실행 코드는 객체 검출의 정확도가 0.3 이상의 정과가 검출되면 컨베이어 벨트의 정방향 제어를 실행하여 사과가 정과 박스로 이송되게 하며, 정확도 0.3이상의 흠과가 검출되면 컨베이어 벨트의 역방향 제어를 실행하여 사과가 흠과 박스로 이송되도록 설정하였다. Fig. 6 및 Fig. 7은 본 연구에서 사용된 사과 선별기의 모니터에서 정과와 흠과가 포착되는 장면을 나타낸 그림이다. 카메라가 이미지를 포착할 수 있는 구간 내에서 사과의 표면 결함이 발견되지 않으면 시스템은 정과로 인식하며, 구간 내에서 사과의 표면 결함이 1회 이상 발견되면 시스템은 즉시 흠과로 판정하고 이미지 분석을 중단한다.

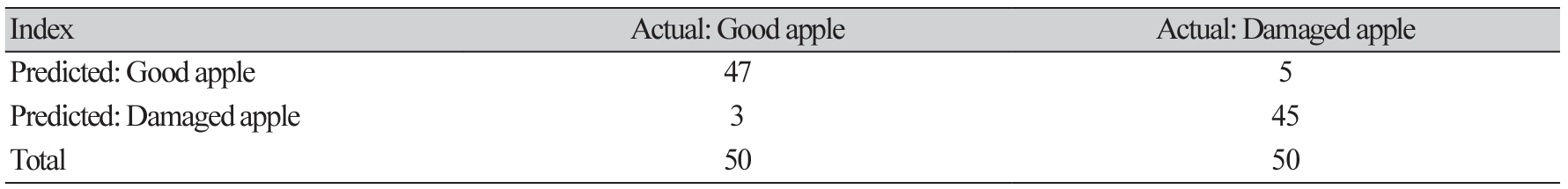

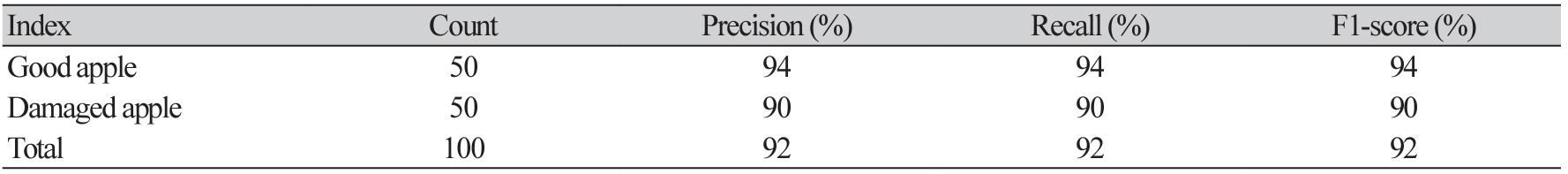

Table 4 및 Table 5는 본 연구에서 개발한 사과 선별기의 선별 정확도를 확인하기 위해 진행한 실험 결과를 나타낸 표이다. 실험은 정과 50회, 흠과 50회 총 100회의 이미지 분석을 수행하였다. 실험 결과는 Confusion matrix로 정리하였으며, 결과값을 정밀도, 재현율, F1-스코어로 나타냈다. 투입된 정과 50개 중 올바르게 인식된 정과의 개수는 47개, 흠과 50개 중 올바르게 인식된 흠과의 개수는 45개였다. 100회의 사과 선별 실험에 대한 정확도는 92%로 나타났으며, 사과 객체 1개 당 영상처리를 이용하여 선별하는데 소요되는 시간은 평균 0.8초로 나타났다. 선별 오류가 발생한 이유는 사과 이미지 데이터 부족, 카메라 대수 1대로 인한 사과 흠결의 미검출 및 조명의 변수로 인한 오검출로 판단된다. 따라서 정과 및 흠과의 이미지 데이터 학습을 추가로 진행하고 본체 내 카메라 대수를 추가한다면 흠과 사과의 미검출이 보완될 것으로 판단된다. 또한 사과 인식 구간의 모든 부분에 빛이 일정하게 들어갈 수 있도록 조명을 조절한다면 오검출이 보완되어 사과 선별의 정확도를 향상시킬 수 있을 것으로 기대된다.

사과 선별 시스템을 개발하여 농가에 보급된다면 육안선별로 진행되고 있는 흠과 선별의 자동화를 기대해 볼 수 있다. 본 연구에서 개발한 사과 선별기는 인공지능을 활용하여 사과의 표면 결함을 감지하므로 사람이 주관적인 판단으로 선별하는 것 보다 높은 정확도를 보일 것으로 예상된다. 그리고 자동화된 시스템을 사용하여 육안선별에 걸리는 시간과 노력을 절약할 수 있으며, 이는 사과 농가의 생산성을 향상시켜 농가의 수익 증대를 기대해 볼 수 있다.

Conclusion

본 연구에서는 과수 농민의 근골격계 질환 예방 및 흠과 선별의 자동화를 위한 사과 선별기를 개발하였다. 흠과 선별은 딥러닝을 기반으로 한 객체 검출기법을 활용하였다. Roboflow와 구글 코랩을 이용하여 사과 이미지 데이터의 라벨링 작업과 학습을 진행하였으며, YOLOv5를 사용하여 정과 및 흠과 사과의 객체 검출 작업을 수행하였다. 또한 객체 검출 결과에 따라 컨베이어 벨트를 제어하여 정과 및 흠과 사과가 자동으로 분류되도록 알고리즘을 구현하였다.

제안된 선별 시스템을 이용하면 수확 후 바로 표면 결함이 있는 흠과 선별이 가능하기 때문에 농민이 육안으로 사과를 선별하는 공정을 축소할 수 있다. 이는 공정에 필요한 인건비와 노동력을 절감할 수 있음을 의미하며, 기존의 육안 선별 대비 균일한 품질선별과 높은 선별 정확도를 기대할 수 있다. 또한 최근 ʻ등급 외’ 과일의 발생 규모는 4조원을 넘어서고 있으며, 흠과 사과는 과수농가에서 수확된 사과의 14.1%를 차지하고 있다. ʻ등급 외’ 사과는 표면이 손상되었다는 이유로 버려지거나 주스 가공용으로 저가에 판매되어 왔지만, 오늘날 “못난이 사과”, “보조개 사과”와 같이 흠과를 합리적인 가격으로 판매하는 상품이 출시되어 흠과의 수요가 증가하고 있다. 따라서 본 연구의 선별 시스템을 이용하여 과수 농민은 흠과에 대한 부가 수익을 창출할 수 있을 것으로 기대된다. 본 연구에서 더 나아가 추후 근적외선 비파괴 선별 시스템을 이용한 내부 갈변사과의 선별 기능이 결합된다면 종래의 사과 선별 시스템의 기계화 및 자동화를 보다 발전시킬 수 있을 것으로 기대된다.

Acknowledgements

본 연구는 농림축산식품부와 농림식품기술기획평가원의 “전기구동 사료작물 수확기 플랫폼 설계 검증 및 최적화(2/4)”의 지원을 받아 수행된 연구 결과입니다 (No. 322045-04).

Authors Information

Donggun Lee, Department of Bio-industrial Engineering, Kyungpook National University, Graduated Student

Jooseon Oh, https://orcid.org/0000-0001-7497-245X

Youngtae Choi, Department of Bio-industrial Engineering, Kyungpook National University, Undergraduate student

Donggeon Lee, Department of Bio-industrial Engineering, Kyungpook National University, Undergraduate student

Hongjeong Lee, Department of Bio-industrial Engineering, Kyungpook National University, Undergraduate student

Sung-Bo Shim, https://orcid.org/ 0000-0002-9854-6428

Yushin Ha, https://orcid.org/ 0000-0002-9434-8694