Introduction

무인화 농업은 실시간 센싱, 데이터 분석 및 자동 제어 등을 통해 농업생산 자율화가 가능한 시스템으로, 최근 농업의 노동력 감소, 기후변화, 생산량 저하 등에 따른 식량 안보 문제의 해결이 가능한 기술적 대안이다(Shalal et al., 2015). 특히, 세계 인구수가 2050년 100억으로 예상되며 농업인 고령화 현상의 심화에 따라 농업인력 대체 및 고효율 생산이 가능한 무인화 농업 실현의 요구는 지속적으로 증대되고 있으며, 이에 따라 농업기계 분야를 중심으로 다양한 관련 연구가 추진되고 있는 실정이다(Lutz and Kc, 2010).

트랙터는 대표적인 농업기계로 다양한 작업기 부착이 가능하여 범용적인 농작업에 사용될 뿐만 아니라, 다른 농업기계에 비해 전자화, 자동화 등 첨단화되어 있어 활용범위가 꾸준히 넓어지고 있다(Kim et al., 2018). 무인화 농업에 대한 필요성 증대에 따라 트랙터를 중심으로 무인 농업기계 시장이 형성되고 있으며, 무인 트랙터 개발을 위한 핵심기술 확보 및 제품화가 활발히 추진되고 있다(Kim et al., 2019). 자율주행은 무인 트랙터의 핵심기술 중 하나로써 현재 작업환경 및 경로를 인식하고 이를 추종하는 기술이며, 농업용 트랙터의 경우 1950년부터 관련 연구가 꾸준히 수행되어 오고 있다(Ming et al., 2009). 대부분의 연구는 GNSS (global navigation satellite system) 기반의 사전경로 생성 및 이를 추종하기 위한 트랙터 조향 제어를 수행하였으며, GPS (global positioning system) 등의 위성 기술을 이용하였다(Stombaugh et al., 1999; Bell, 2000; Lenain et al., 2010; Bakker et al., 2011). 이와 같은 접근은 절대 좌표 제공의 장점을 가지지만 고정밀 GPS 시스템의 높은 가격, 캐노피(canopy) 등 작물환경에 따른 위성신호 수신 불확실도 등으로 인해 농업분야에서 제품화하는데 한계가 있다. GPS 기반 무인 트랙터 기술의 한계를 극복하기 위해 최근 기계시각(machine vision)을 이용한 실시간 환경 인식 및 경로 생성 기술이 제안되고 있으며, 라이다(lidar) 기반 스캐닝(Malavazi et al., 2018), 스테레오 비전 등 3D 영상(Wang et al., 2018)을 이용한 다양한 영상 인식 연구가 진행되고 있다. 특히, 합성곱신경망 기반 영상 인식 등의 딥러닝(deep learning) 기술은(LeCun et al., 1998) 학습 기반의 객체의 공간적 특징(spatial feature)의 자동추출이 가능한 기술로써 휴리스틱(heuristic) 기반 영상처리 등 기존 방식에 비해 높은 성능을 보여주고 있으며(Chun et al., 2018), 분류문제의 경우 ImageNet Large Scale Visual Recognition Competition (ILSVRC) 등을 통해 이미 인식율이 90% 이상으로 인간수준까지 성능을 향상시켰다(Krizhevsky et al., 2012; Stefas et al., 2019). 농업분야에서도 최근 딥러닝 기반 연구가 활발히 진행되고 있으며 주로 작물의 질병 인식, 병해충 검출, UAV (unmanned aerial vechicle) 기반의 작물열 및 잡초 인식 등을 중심으로 연구가 추진되었다(Kamilaris et al., 2017). 대부분의 연구가 객체 검출에 관련된 목적으로 수행 및 높은 수준의 자동인식율을 보여주었으며, 경로인식과 관련해서는 과수원의 나무 검출 기반의 경로 예측(Shalal et al., 2015), 작물 열 인식을 위한 딥러닝 모델 개발(Dian Bah et al., 2019) 등이 수행되었다. 하지만 경로의 직접적인 검출이 아닌 객체 인식을 위해 딥러닝이 주로 사용되었으며, 실제 경로는 라이다 등의 추가정보를 이용하여 검출하였다. 또한, 작물 열 인식의 경우 주로 UAV 영상 등을 이용한 맵핑정보 제공 목적의 연구로 진행되었으며 자율주행을 위한 경로인식과는 차이가 있다. 2D 영상 기반의 딥러닝 기술을 통해 작업경로를 자동 검출 한다면 라이다, GPS 등 고가 시스템 없이 농업기계 자율주행 기술 개발이 가능하다.

본 연구에서는 무인 자율작업 트랙터 개발의 기초 연구로써 2D 기계시각을 이용하여 트랙터 경운작업 시 주행기준선을 자동으로 검출하는 기술을 개발하였다. 딥러닝 기반 영상학습을 통해 정면영상의 구역별 부류(경작 전, 경작 후, 배경)를 분류한 후 부류의 경계를 이용하여 주행기준선을 검출하였으며 실제 트랙터 주행을 통해 촬영된 정면영상을 이용하여 주행기준선 검출 성능을 평가하였다.

Materials and Methods

경운작업 영상 특징

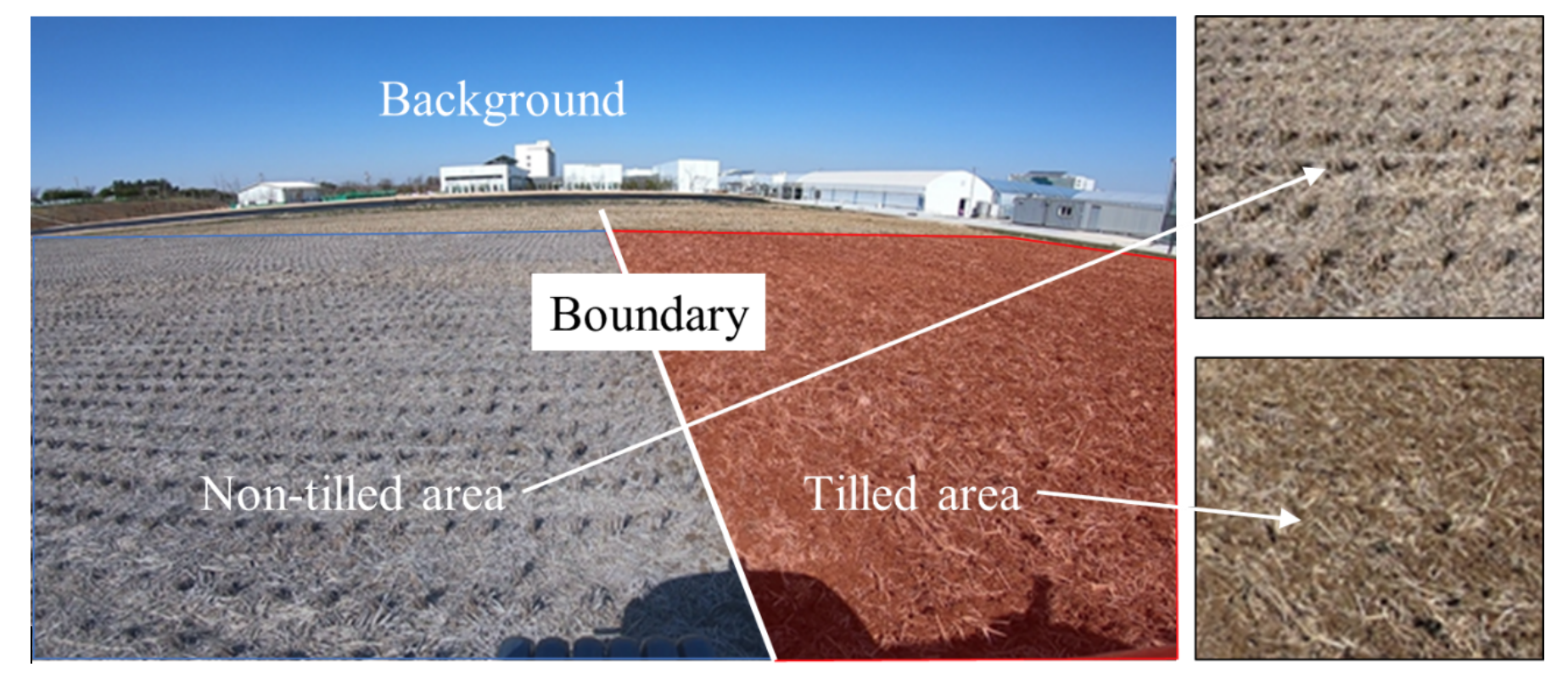

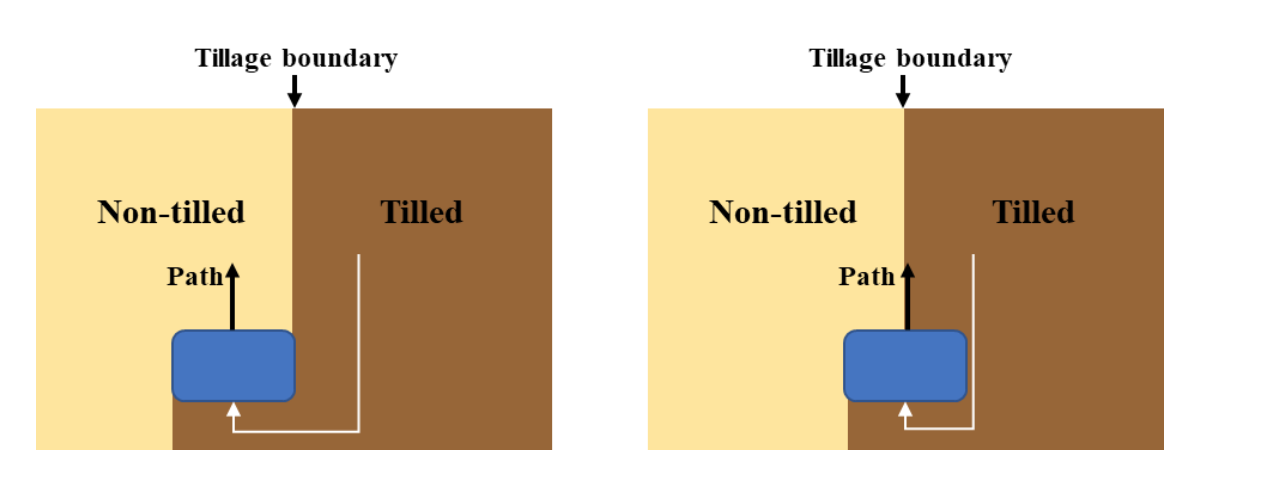

트랙터 밭 경운작업 시 주행정면의 영상은 일반적으로 Fig. 1과 같이 경작 전, 후 및 배경의 3가지 영역으로 크게 구분된다. 경작 전의 밭은 수확되고 남은 작물의 일부가 토양에 남아있어 작물의 일정한 조간, 주간에 따라 반복적인 패턴형태가 관찰된다. 반면에 경작 이후의 영역에서는 쟁기 등의 트랙터 작업기의 쇄토로 인해 토양 표면의 패턴형태가 존재하지 않으며, 표면 아래의 토양과 섞여 경작 전 토양과 색상의 차이를 다소 보여준다. 경작 전, 후 토양의 패턴 및 색상 등의 차이로 발생되는 경계선이 두 영역의 경계인 동시에 경운작업을 위한 주행의 기준이 된다(Han et al., 2019). 트랙터는 경운 시 본 경계선을 기준으로 경작 전 영역 위를 주행 및 작업하게 되며, 경운작업 면적의 중첩 기준이 높을수록 주행기준선은 Fig. 2와 같이 트랙터 중심에 가까워진다. 이때 경운작업 중첩율이 50%일 경우, 이전 경작된 면적의 절반이 다시 포함되므로 주행기준선은 트랙터 중심에 위치하는 동시에 추종해야 되는 경로가 된다.

영상의 하단에 가까울수록 경작 전, 후의 구분이 명확하게 육안으로 확인되며, 상단에 가까울수록, 즉 배경과 인접할수록 원근에 따른 왜곡으로 픽셀(pixel) 거리 대비 포함면적이 증가되어 영역의 구분이 모호해짐을 알 수 있다.

경운작업 경계 검출

경계 검출 프로세스 개요

본 연구에서는 입력된 영상의 구역별(부분영상) 분류를 기반으로 전체영상에서 검출대상 영역을 군집화하고 영역 간 경계를 인식하여 경운 시 주행기준선을 검출하였으며, 구역별 분류는 딥러닝 학습 기반의 간단한 분류 모델을 이용하여 부류 결정 및 영역에 대한 점수를 평가하였다.

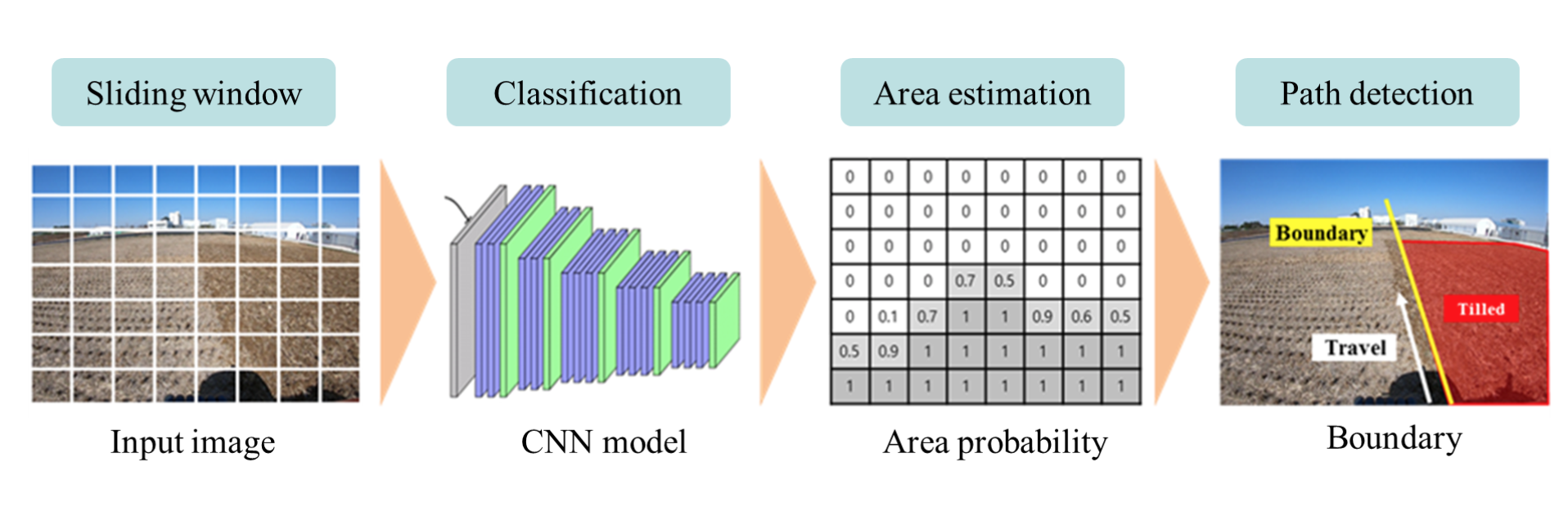

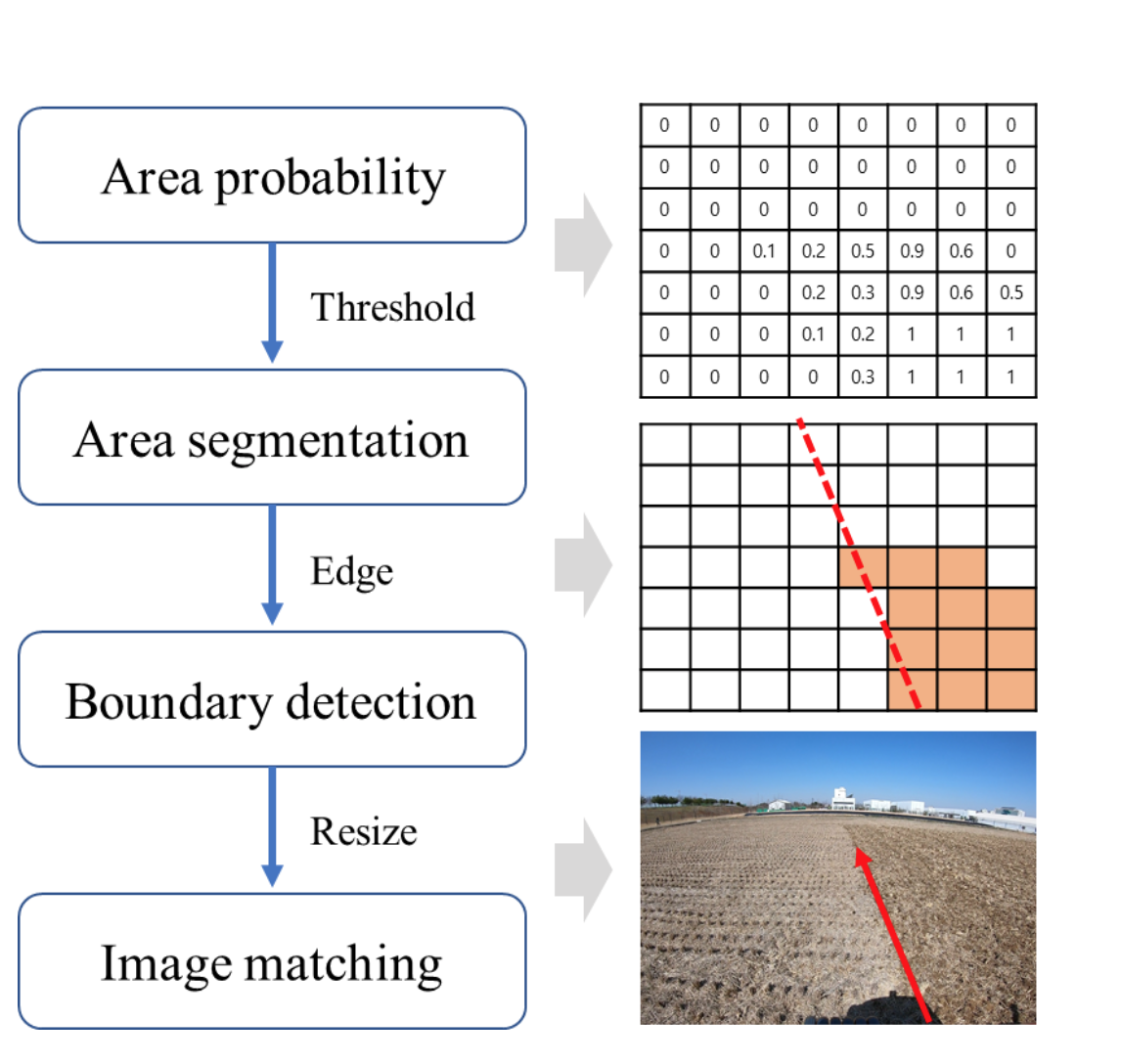

트랙터 경운작업 시 경계(주행기준선) 검출의 전체 프로세스는 Fig. 3과 같이 영상 구역화, 영상분류, 영역분할, 경계 검출의 총 4단계로 구성되었다. 영상 구역화는 고화질 영상을 구역(부분)영상으로 나누는 작업으로 영상분류모델의 입력에 사용되는 크기로 원 영상의 좌측상단부터 우측하단 순서로 복수의 구역 영상들을 생성한다. 영상분류는 영상 구역화를 통해 생성된 입력영상들을 이용해 분류모델을 학습하고 이를 이용해 영상을 경작 전, 경작 후, 배경의 3가지 부류(class)로 분류한다. 이때 분류모델은 합성곱신경망(convolutional neural networks, CNN)을 기반으로 구성하였다. 각각의 구역별 영상들의 부류에 대한 확률값을 기반으로 경작 후 영역을 분할한 후 경작 전과의 경계선 즉, 경운작업의 주행기준선을 검출하였다.

영상학습 모델

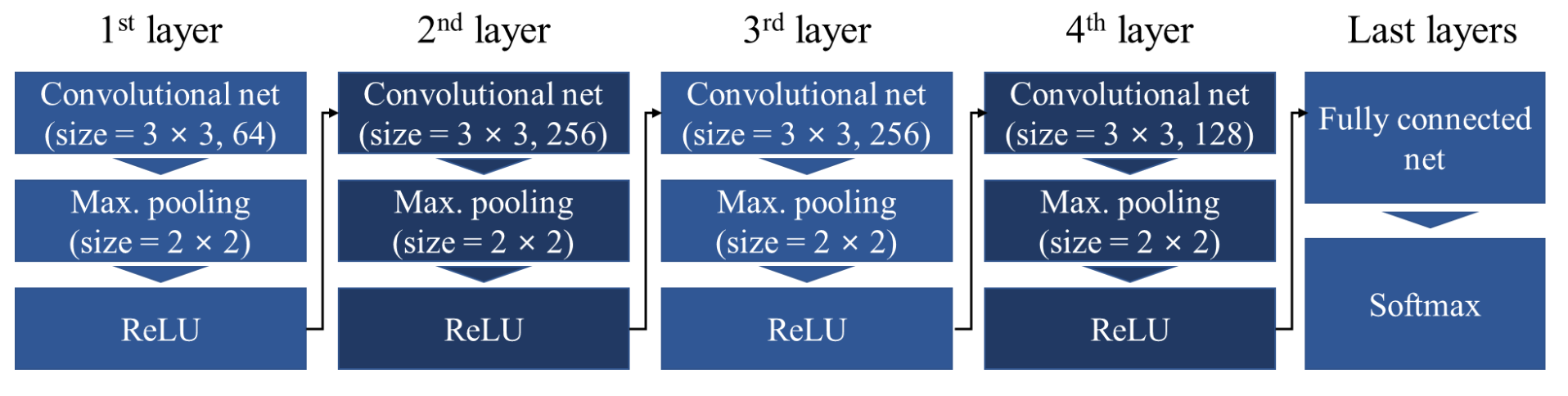

구역별 영상 부류의 분류는 합성곱신경망 모델을 이용하였으며, 본 연구에서 사용된 합성곱신경망 구조는 Fig. 4와 같이 4개의 합성곱신경망 층(layer), 1개의 완전연결망(fully connected network) 층과 softmax 분류기로 구성되었다. 입력되는 구역별 영상의 크기는 112 × 112 × 3 (width × height × channel) 픽셀이며, 합성곱신경망의 필터 크기는 3 × 3으로 전체 층에서 동일하고, 활성화 함수로는 ReLU (rectified linear unit)을 이용하였다. 이때 입력 영상의 크기는 카메라에서 가장 가까운 영상 하단을 기준으로 경작 후 영역의 패턴이 최소 1개 이상 포함되기 위한 최소크기를 선정하였다. 입력된 영상의 분류 결과는 softmax 분류기에서 3개의 부류에 대한 확률값으로 출력되며, 이 중 가장 높은 확률값을 가진 부류로 분류된다. 이때 경작 후 영역에 대한 확률값을 이용하여 영역분할이 수행되었다.

합성곱신경망 모델의 학습을 위해 국립농업과학원 농업공학부에 위치한 농작업 시험지에서 4월경 트랙터 경운 작업을 실시하였다. 작업 시 정면영상 촬영을 위해 트랙터 보닛(bonnet) 위에 액션캠(Hero7, GoPro, San Mateo, USA)을 설치하였으며, 약 60 m를 왕복 주행하면서 동영상을 촬영하였다. 이때 액션캠의 설치높이는 약 1.6 m이며 화각(field of view)는 수직 69.5°, 수평 118.2°이다. 동영상은 30 fps 속도로 Full-HD의 정밀도, 1920 × 1080 픽셀의 크기로 촬영 및 저장되었으며, 촬영 시 날씨는 맑고 기온은 약 10°로 관찰되었다. 수집된 영상에서 육안으로 구분가능한 경작 전, 후 및 배경 부류를 각각 112 × 112 픽셀 크기로 해당부류가 90% 이상 포함되도록 잘라내어 학습데이터로 사용하였으며, 전체 학습데이터는 각 부류별 300장씩 총 900장으로 구성되었다. 이때, 전체데이터는 학습, 검증, 시험데이터로 분류하였으며, 각각 500, 300, 100장이다.

모델은 GPU (GeForce 1080ti, Nvidia, Santa Clara, USA) 기반으로 시스템으로 학습시켰으며, 기능 구현을 위한 프로그램은 파이썬(version 3.7, Python Software Foundation, Wilmington, USA) 및 딥러닝 프레임워크(Tensorfolw, Google, Mountain View, USA)을 이용하였다. 또한 영상처리 라이브러리(opencv, Intel co., Santa Clara, USA)를 통해 결과를 시각화하였다.

영역분할 및 경계검출

전체영상은 구역별 영상으로 분할된 후 순차적으로 영상학습 모델의 입력으로 전달되며, 영상 분할은 전체영상의 좌측상단에서 우측하단 방향으로 이동창(sliding window) 방식으로 진행된다. 이때, 각각의 인접영상 간에는 50% 중첩시켜 영역의 불연속을 최소화하였다. 각각의 입력영상에 대해 3가지 부류의 확률값이 softmax 분류기를 통해 출력되며(Kim et al., 2020), 일반적으로 가장 높은 확률값을 가지는 부류를 입력영상의 부류로 분류된다. 구역별 영상들의 경작 후 부류에 대한 확률값들을 이용하면 Fig. 5와 같이 임계처리(threshold), 경계검출(edge detection) 등을 통해 경작 후 영역에 대한 분할 및 경운경계의 검출이 가능하다. 각각의 구역에 대한 경작 후 부류의 확률값을 원 영상에서의 위치를 기준으로 결합하면 2차원의 확률맵이 생성되며 이를 임계처리하여 전체영역에서 경작 후 영역을 분할할 수 있다. 이때 임계처리의 기준값은 분류기 결과에서 경작 후 영역 부류가 선정되기 위한 최소값인 0.5를 이용하였다. 분할된 영역은 측면과 상단에서 각각의 경계를 가지고 있으며, 측면이 경작 전 영역과 맞닿아 있는 주행기준선이다. 따라서 좌측 경계점들을 검출한 후 허프변환(hough transformation)을 이용하여 대표직선을 생성하였으며(Shehata et al., 2015), 이를 원 영상에 다시 매칭하여 경운작업 경계로 선정하였다.

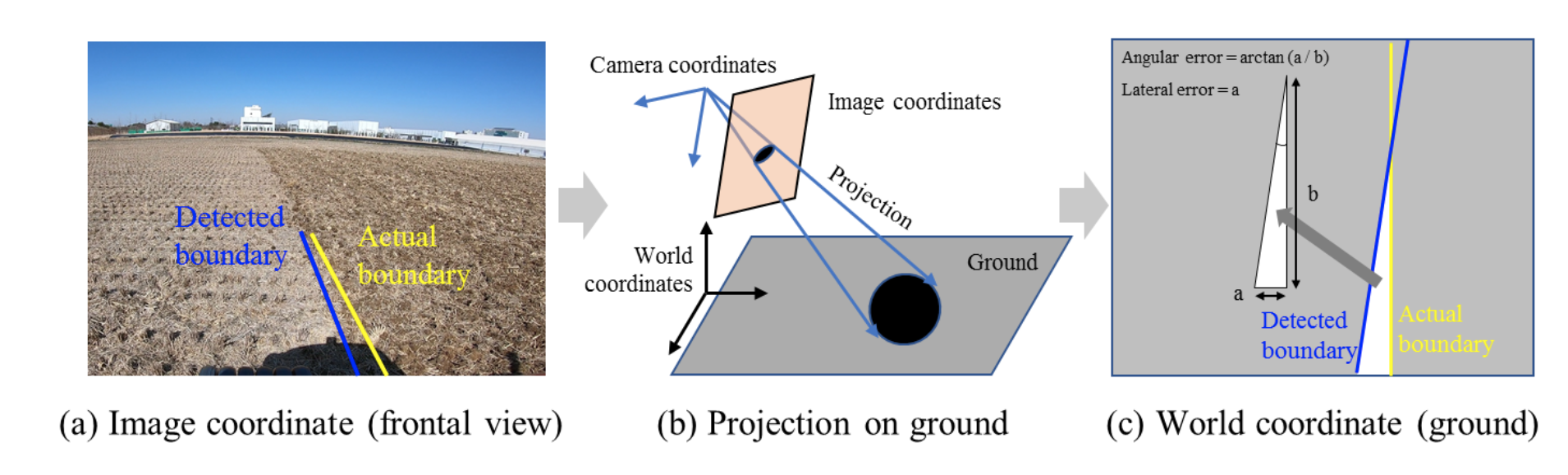

성능평가 방법

제안된 기술의 성능은 합성곱신경망 모델의 분류, 영역 분할, 경계 검출에 대해 평가하였다. 합성곱신경망 모델의 분류 성능은 식(1)과 같이 F1-score 지표를 이용하여 분류 정확도를 평가하였으며, 식(2), (3)의 재현율(recall), 정밀도(precision)를 이용하여 계산된다(Kamilaris et al., 2017). 영역 분할에 대한 성능은 컬러맵(color map)을 이용하여 2D의 확률맵을 가시화하였으며(Zhou et al., 2016), 실제 영역과 검출된 영역의 중첩된 정도를 관찰하였다. 경계 검출에 대한 성능은 일반적으로 자율주행 기술의 평가지표로 많이 사용되는 횡방향 오차(lateral error), 각도 오차(angular error)를 이용하였으며, Fig. 6과 같이 2D 영상을 지면에 투영시켜 실제 경계와 검출된 경계의 횡방향 거리, 각도 차이를 계산하였다. 이때 지면에 투영은 작물의 식(4)를 이용하여 영상 좌표계(image coordinate)에서 실제 지면 좌표로 변환시킨 후 경계선에 해당되는 각 픽셀을 지면에 매칭시켰으며(Lee et al., 2019). 횡방향 오차는 Fig. 6(c)와 같이 두 경계의 최대 수평거리, 각도 오차는 두 경계가 이루는 예각을 아크탄젠트(arctangent)를 이용하여 계산하였다.

(1)

(1)

(2)

(2)

(3)

(3)

Where, TP (true-positive) is correct classification at positive label

FP (false-positive) is incorrect classification at positive label

FN (False-negative) is incorrect classification at negative label

Px, y, z = Cx, y, z + k(px, y, z − Cx, y, z) (4)

Where, k is parameter for Pz=0,

Px, y, z=0 is projected point onto ground

Cx, y, z is camera origin position in world coordinates

px, y, z is image pixel position in world coordinates

Results and Discussion

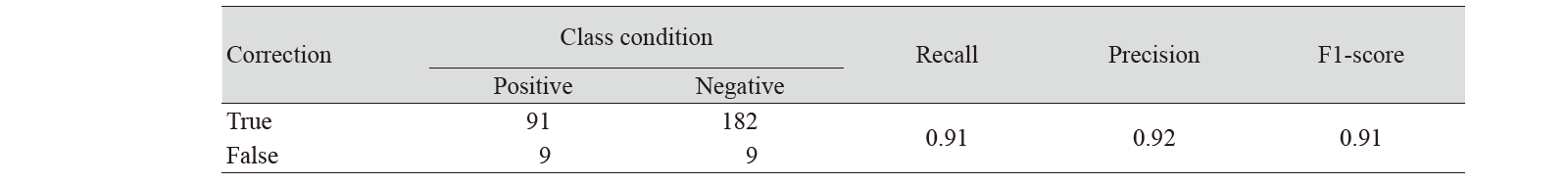

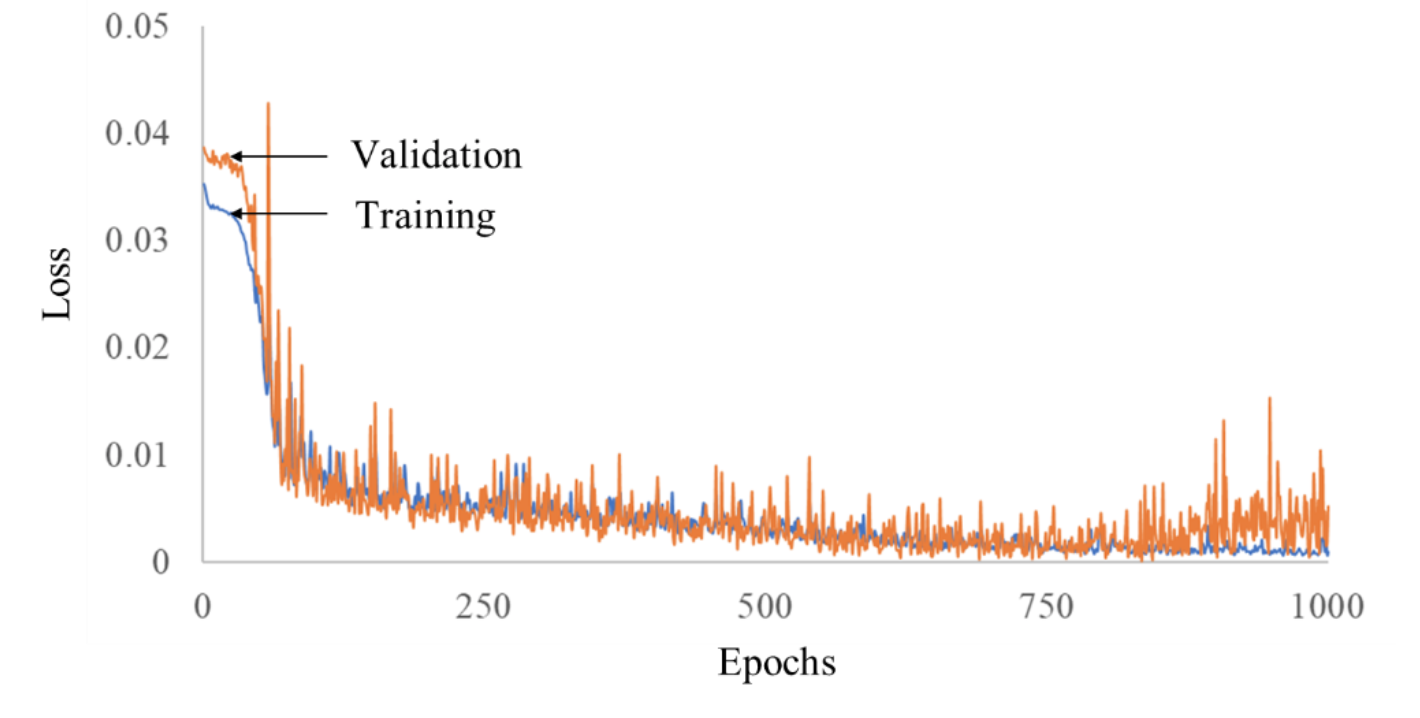

Classification accuracy

합성곱신경망 모델은 학습데이터 500장을 이용해서 반복 학습하였으며, 과적합(overfitting) 효과를 최소화하기 위해 검증 데이터의 분류 성능이 가장 좋을 때 학습을 종료하였다(Kim et al., 2020). 반복학습에 따른 손실(loss)는 Fig. 7과 같이 나타났으며, 분류 손실은 학습데이터의 경우 지속적으로 감소되었지만, 검증데이터의 경우 800회에서 가장 낮은 값을 가진 후 점차 상승되었다. 따라서 800회 반복 학습 시 모델 가중치를 본 연구의 분류 모델에 사용하였다. 학습된 합성곱신경망 모델을 이용한 시험데이터의 분류 성능은 Table 1과 같으며, 정확도는 F1-score 0.91로 관찰되었다. 이때 각각의 수치는 부류별 성능의 평균값이다. 딥러닝 기반 농업영상 내 객체 분류 및 검출 연구에서 F1-score가 약 0.92 수준으로 보고되었으며(Kamilaris et al., 2017), 본 연구의 4개층의 합성곱신경망이 기존 연구에 비해 비교적 가벼운 구조를 가짐에도 불구하고 유사한 성능을 보여줌을 알 수 있다. 특히, 사용된 학습데이터의 경우 원근에 따라 샘플 간 스케일의 차이가 있었지만 합성곱신경망 기반의 학습으로 강인한 분류가 가능하였다. 따라서, 본 연구에서 사용된 합성곱신경망 모델이 가벼운 구조로 빠른 속도의 영상 분류가 가능할 뿐만 아니라 높은 정확도로 영역 검출이 가능한 것으로 판단된다.

Tillage boundary detection

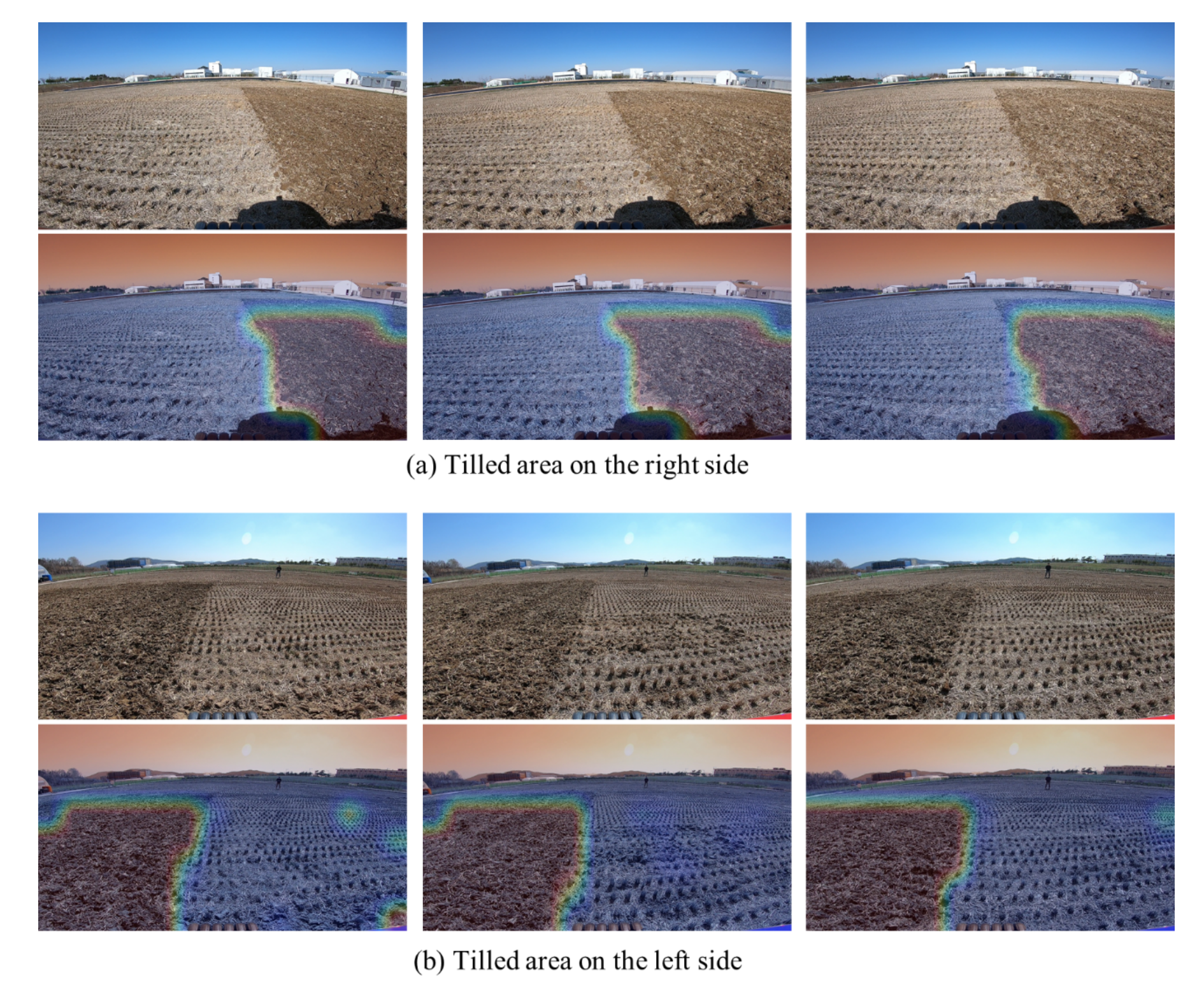

Fig. 8은 경작 후 영역의 분할 결과로 대표적인 6개의 영상에 대해 시각화하였다. 분할된 영역은 합성곱신경망 모델의 분류기로부터 출력된 확률값을 이용하여 생성되며, 각 구역별 영상의 경작 후 영역에 해당되는 확률값들을 원 영상에서의 위치를 기준으로 통합시킨 결과로 컬러맵을 이용하여 표현되었다. 이때 각 컬러맵은 히트맵(heatmap)을 이용하여 원 영상과 중첩시켜 표현하였으며, 빨간색에 가까울수록 해당 영역이 경작 후 영역일 확률이 높은 것을 의미한다. 대부분의 영상에서 경작 후 영역이 실제 영역과 경계에서 다소 차이가 발생되었지만 대부분의 영역에서 일치됨을 알 수 있었다. 또한, 경계를 중심으로 히트맵의 색상 변화가 좁은 구간에서 이루어지는 것으로 관찰되어 임계값 0.5를 기준으로 경계 검출이 원할한 것으로 판단된다. 영상 상단의 경계의 경우 경작 후 영역으로 분할되지 못한 영역도 일부 존재하였는데, 이는 거리에 따른 2D 영상의 왜곡 및 소실점 등으로 인해 단위면적당 실제 면적이 증가하여 영역 구분을 위한 특징 검출이 어려워졌기 때문이다. 또한 검출영역이 존재하는 위치에 따라(경계의 좌, 우) 분할결과의 차이를 보였으며, 이를 통해 학습기반 영상인식이 휴리스틱 기반의 영상처리에 비해 환경에 강인한 영상특징 검출 및 높은 성능을 보이지만(Kamilaris et al., 2017), 촬영방향에 따른 명도, 채도 등의 변화에 따라 성능의 차이가 다소 발생됨을 알 수 있다. 대부분의 영상에서 경작 후 영역의 분할이 가능하였으며, 추가적인 성능 향상을 위해서는 분류모델의 입력이 되는 구역별 영상의 크기를 축소하여 영상분할 해상도를 향상시키거나 합성곱신경망의 계층 확장을 통한 특징추출 성능 향상시키는 등의 최적화가 필요할 것으로 판단된다. 처리속도의 경우 1개의 영상당 약 150 ms 이내로 처리가 가능하였으며, 전체과정 중 입력영상의 분할 및 학습기반 분류과정에서 약 120 ms 정도로 80% 수준을 차지하였다.

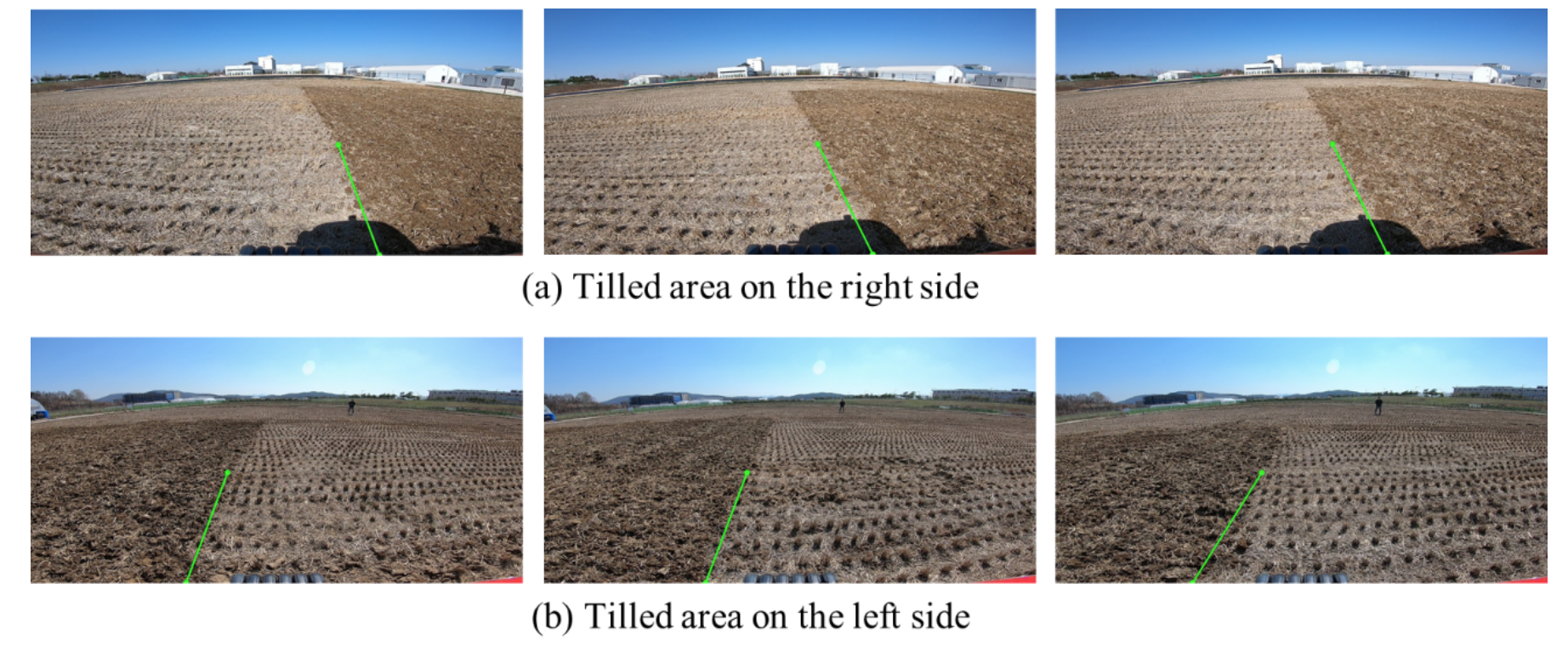

Fig. 9는 선정된 경운작업을 위한 주행기준선을 보여준다. 분할된 경작 후 영역의 측면 경계를 이용하여 경계선을 검출하였으며, 허프변환을 이용하여 경계를 포함하는 직선을 생성하였다. 대표적인 결과에서 확인할 수 있듯이, 대부분의 경우 높은 성능으로 경계 검출이 가능하였으며, 특히, 오른쪽에 경작 후 영역이 존재하는 영상에서는 하단의 트랙터 그림자가 존재하고 있음에도 불구하고 실제경계와 검출된 경계가 유사하게 나타났다.

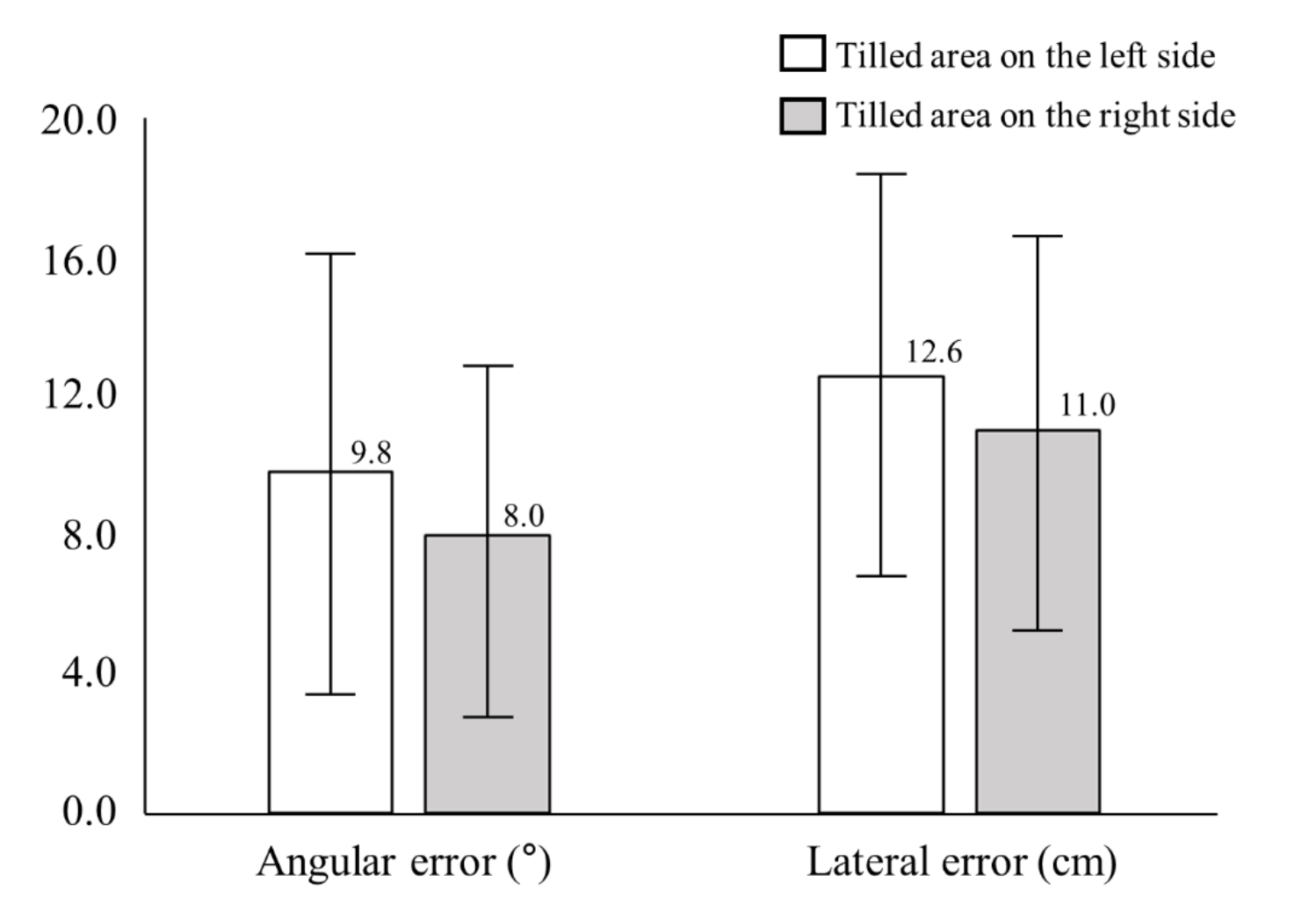

검출된 경계와 실제 경계 사이의 차이를 분석하였으며, 그 결과 Fig. 10과 같이 나타났다. 오차는 영역이 존재하는 방향별 평균값으로 표현되었으며, 각도 오차의 경우 경작 후 영역이 우측에 존재할 때 평균 8.0º로 좌측의 경우 평균 9.8º의 82% 수준으로 더 높은 성능을 보였다. 각도오차의 최소, 최대 사이의 범위에서도 영역이 우측에 존재할 때 10.2º으로 좌측의 경우인 12.6º보다 더 작게 나타났다. 횡방향 오차에서도 각도오차와 같이 경작 후 영역이 우측에 존재할 때 평균 11.0 cm로 좌측의 경우인 12.6 cm에 비해 약 12% 낮게 관찰되었다. 최대 횡방향 오차는 영역이 좌측에 존재하는 영상에서 18.3 cm로 나타났으며, 최소값은 5.4 cm로 반대의 경우에서 관찰되었다. 횡방향 오차는 Li et al. (2019)의 자율주행 농업기계 연구의 성능 RMSE (root mean square error) 약 7 cm에 비해 다소 높게 나타났지만 본 연구에서 사용된 경운 작업기의 폭이 220 cm임을 고려했을 때, 검출된 기준으로 작업 시 평균 횡방향 작업오차는 약 5% 수준으로 계산된다. 또한, 각도오차는 Han et al. (2015)의 GPS 기반 경운 자율주행 결과인 - 8 ~ 5º 보다 다소 높게 나타났지만 GPS 등의 고가 시스템이 없이 구현되었다는 측면에서 현장 활용 가능성이 있을 것으로 판단된다. 따라서, 본 연구를 통해 저가의 2D 영상정보 기반으로 작업경계의 검출이 가능함을 알 수 있었으며, 이를 통해 기존 GPS, LIDAR 등의 시스템에 비해 농업분야에서 실용화 가능성이 높을 것으로 판단된다.

Conclusion

본 연구는 무인 트랙터 개발을 위해 저가의 2D 영상정보만으로 트랙터 경운작업 시 주행기준선의 인식이 가능한 기술 개발하였으며, 딥러닝 기반 인식 기술을 이용하여 트랙터 작업 시 정면영상 내에서 경운 전, 후의 작업 경계선를 검출하였다. 트랙터 경운작업의 경계 검출과정은 영상 구역화, 영상분류, 영역분할, 경계 검출의 총 4단계로 구성되었다. 영상 구역화는 전체 영상을 분류모델에 적합한 부분 영상으로 나누는 작업이며, 이를 통해 얻어진 구역 영상들은 합성곱신경망 모델을 이용하여 경운 전, 경운 후, 배경의 3가지 영역으로 분류되었다. 분류 결과로 출력된 부류의 확률값을 이용하여 경운 후 영역을 전체영상에서 분할하였으며, 허프변환을 이용하여 경계선을 결정하였다. 그 결과, 합성곱신경망의 분류 정확도는 F1-score 기준 0.91로 평가되었으며, 검출된 경계선은 실제 경계선과 비교했을 때, 평균 횡방향 오차는 약 11.4 cm, 평균 각도오차는 약 8.9º로 나타났다.

본 연구결과는 기존에 수행된 농업분야 자율주행 기술의 성능범위 수준을 보여주었으며, 저가의 2D 영상 시스템 및 딥러닝을 이용한 자율주행 농업기계 기술이라는 측면에서 기존 연구에 비해 높은 실용화 가능성 및 넓은 적용 범위의 장점이 있다고 판단된다. 하지만 실제 트랙터 적용 및 필드에서 활용하기 위해서는 다양한 환경에서의 강인한 성능의 검증이 필요하다. 이를 위해서는 영역분할 시 임계값 최적화 등 정밀한 경계처리 등 성능향상이 필요하며 합성곱신경망의 정밀한 특징 추출을 위한 구조 개선, 분류의 단위영상 크기에 따른 효과 분석을 통한 프로세스 최적화, 주요 영역에 대한 영상처리로 시스템 구동 메모리 최소화 등의 기술 적용을 통해 기술의 고도화가 필요할 것으로 판단된다.